MySQL数据集成案例分享:6--BI秉心-退款单表--refundorder_z-->refundorder

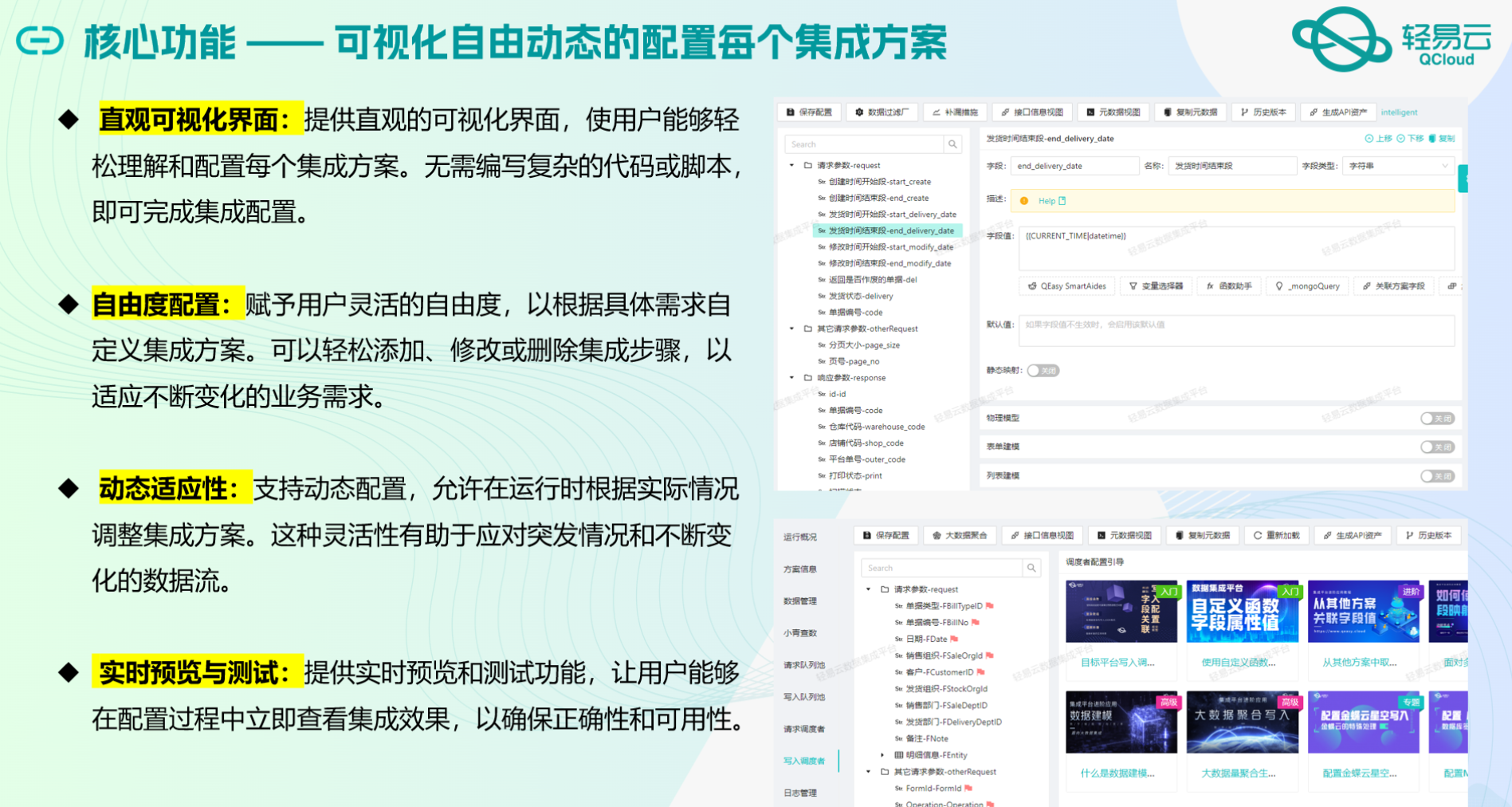

在数据驱动的业务环境中,如何高效、可靠地实现数据集成是每个企业面临的重要挑战。本文将聚焦于一个具体的系统对接集成案例——将MySQL中的退款单表refundorder_z数据集成到目标MySQL表refundorder,并详细探讨该过程中所采用的技术方案和关键特性。

数据源与目标平台概述

本次集成任务涉及两个MySQL数据库之间的数据迁移。源数据库中的退款单表refundorder_z包含了大量需要实时处理和监控的数据,而目标数据库中的refundorder则是最终存储这些数据的位置。为了确保数据在传输过程中的完整性和一致性,我们使用了一系列先进的数据处理技术和工具。

关键技术特性

-

高吞吐量的数据写入能力: 在大规模数据迁移过程中,性能是首要考虑因素之一。本次集成方案利用了高吞吐量的数据写入能力,使得大量退款订单能够快速、安全地被写入到目标MySQL数据库中,从而显著提升了整体处理效率。

-

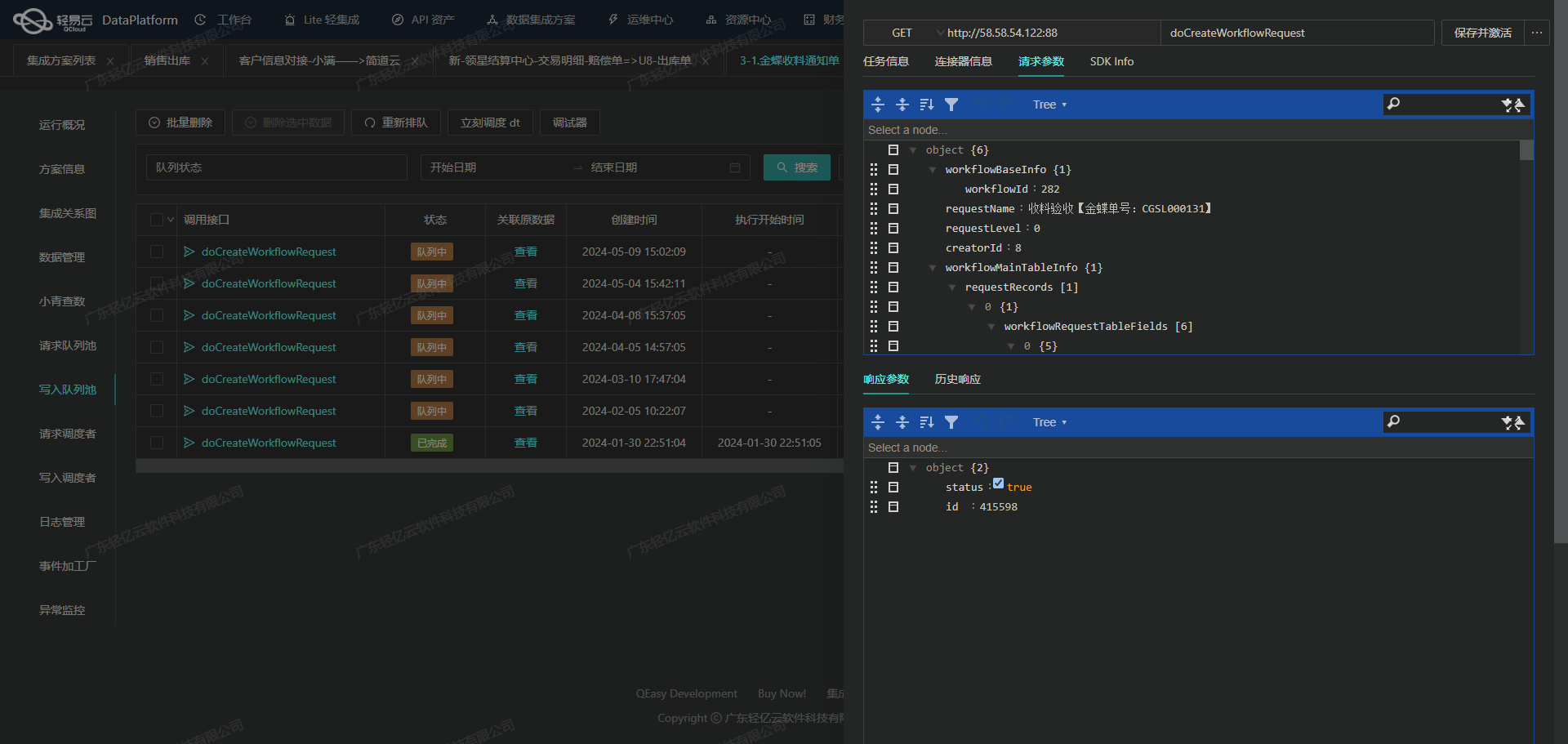

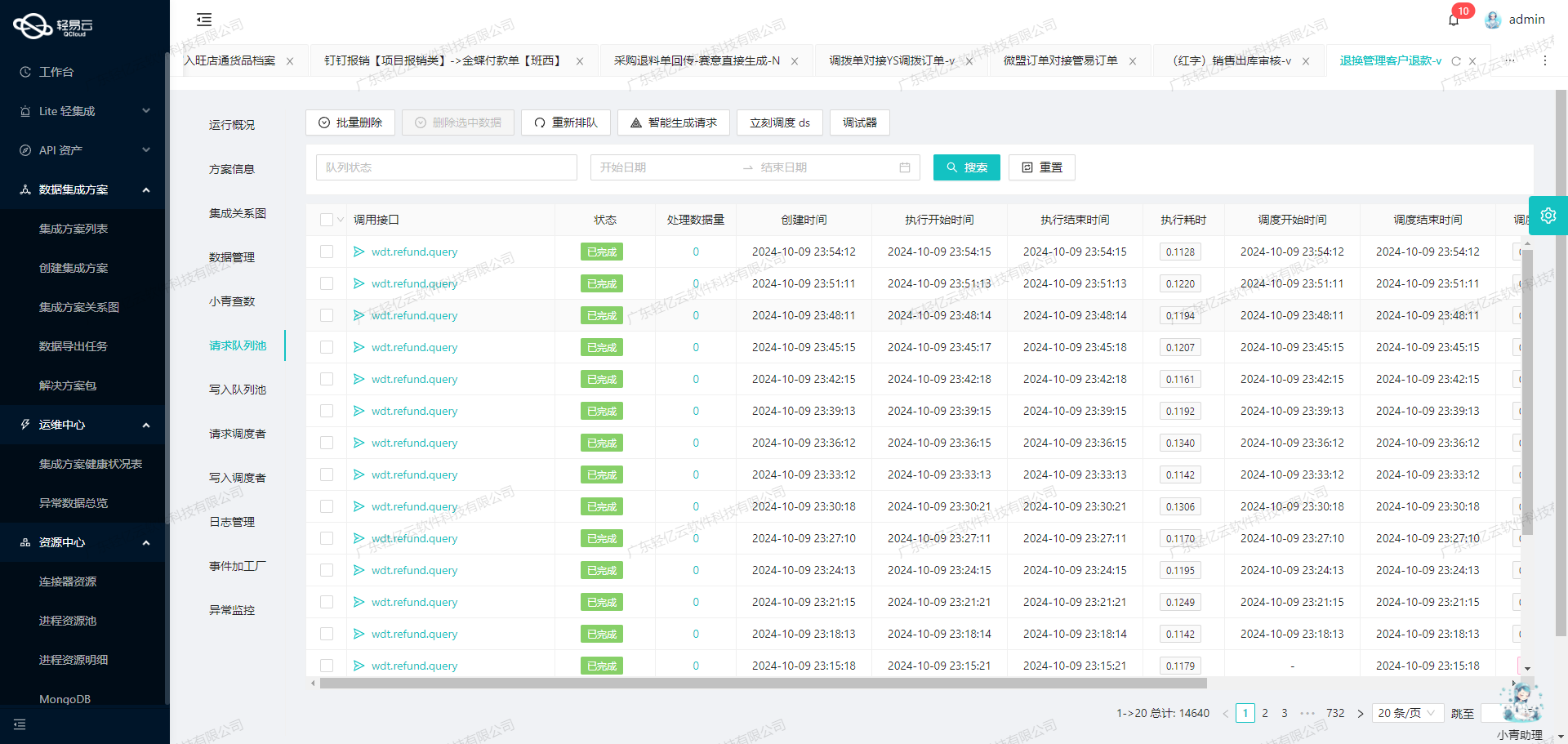

实时监控与告警系统: 为了确保每一步操作都在可控范围内,本次方案配置了集中化的监控和告警系统。通过实时跟踪数据流动状态,我们能够及时发现并解决潜在问题,避免因异常情况导致的数据丢失或延迟。

-

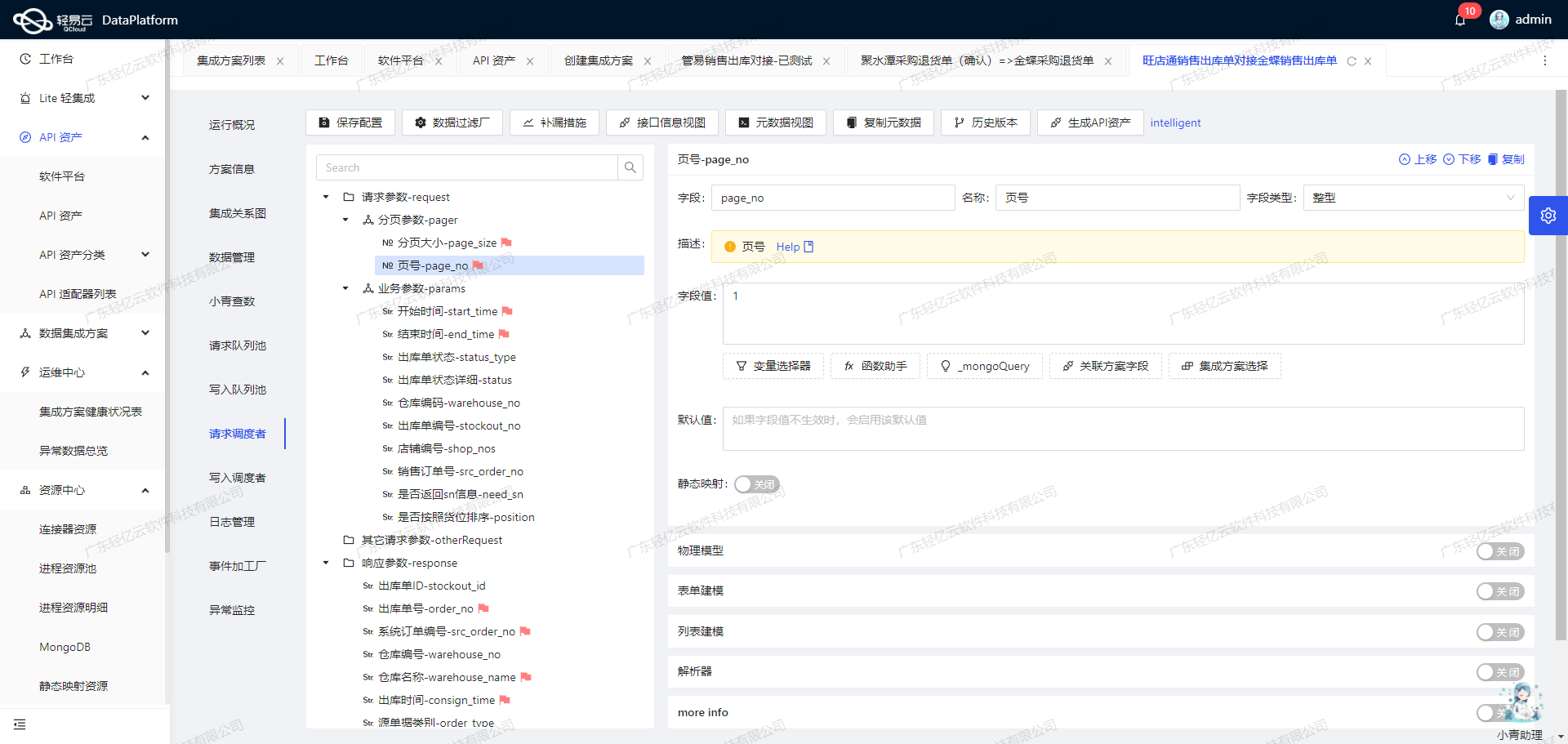

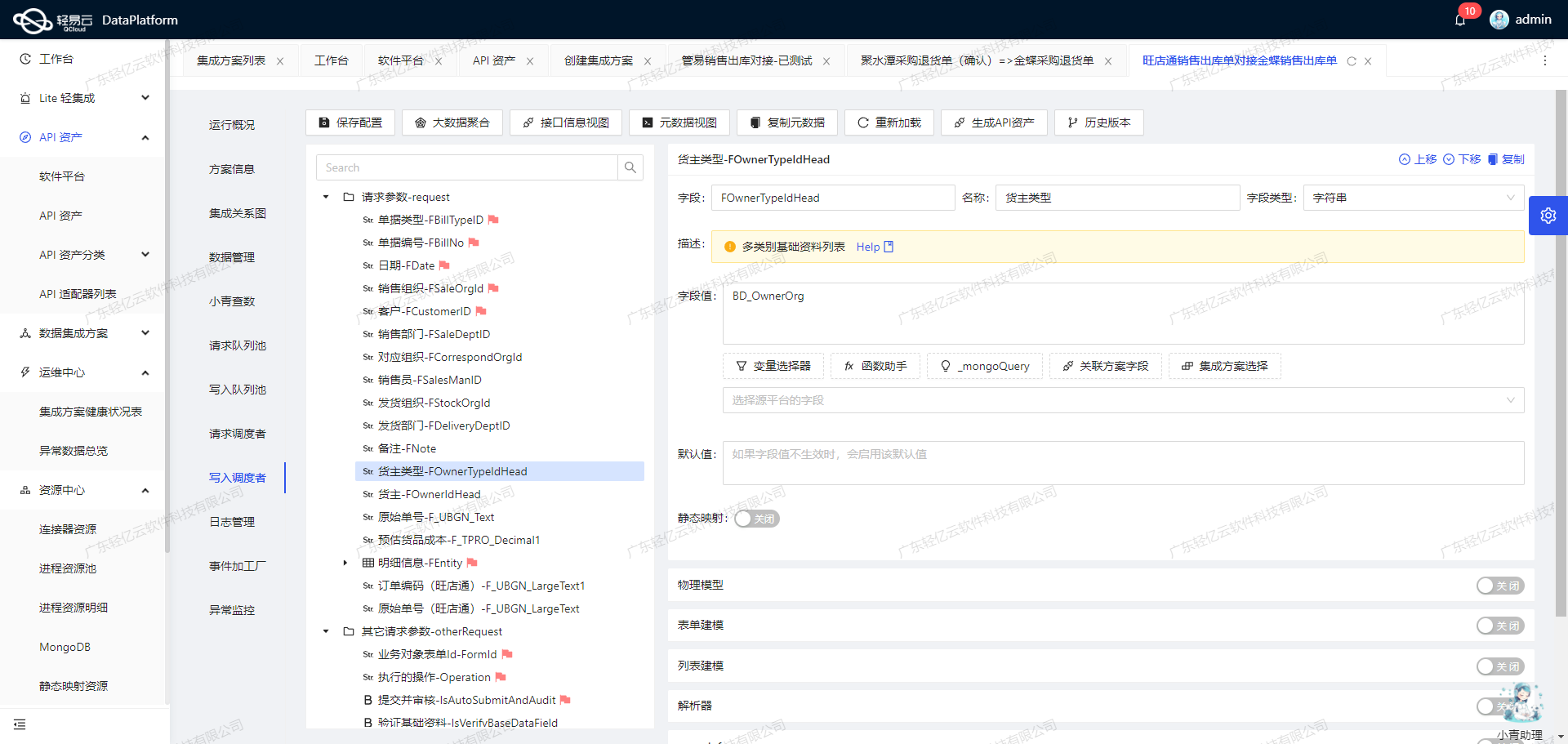

自定义数据转换逻辑: 不同业务场景下,源表与目标表可能存在结构差异。本次方案支持自定义数据转换逻辑,以适应特定的业务需求。例如,在从

refundorder_z向refundorder迁移时,可以根据实际需求进行字段映射和格式转换,确保数据的一致性和准确性。 -

批量处理与分页限流机制: 为了应对大规模数据传输带来的压力,本次方案采用了批量处理机制,并结合分页限流策略,有效控制每次传输的数据量。这不仅提高了传输效率,还降低了系统负载风险。

-

异常处理与错误重试机制: 数据迁移过程中难免会遇到各种异常情况,如网络波动、数据库连接超时等。本次方案特别设计了完善的异常处理与错误重试机制,当出现问题时能够自动进行重试操作,确保任务最终顺利完成。

通过上述技术特性的综合应用,本次MySQL到MySQL的数据集成任务不仅实现了高效、稳定的运行,还为后续类似项目提供了一套可参考、可复制的最佳实践。在接下来的章节中,我们将深入探讨具体实施步骤及其背后的技术细节。

调用MySQL接口select获取并加工数据

在轻易云数据集成平台的生命周期中,调用源系统MySQL接口进行数据获取和加工是至关重要的一步。本文将详细探讨如何通过配置元数据来实现这一过程,并确保数据集成的高效性和准确性。

配置元数据以调用MySQL接口

首先,我们需要定义一个有效的API请求来从MySQL数据库中获取所需的数据。在本例中,我们使用select方法,通过SQL查询语句来提取退款单表(refundorder_z)中的数据。以下是关键的元数据配置:

{

"api": "select",

"effect": "QUERY",

"method": "SQL",

"number": "Id",

"id": "Id",

"request": [

{

"field": "main_params",

"label": "主参数",

...

}

],

...

}参数化查询与分页处理

为了提高查询效率和安全性,我们采用参数化查询方式,并结合分页处理。具体来说,使用LIMIT和OFFSET子句来控制每次查询返回的数据量,从而实现批量抓取和分页处理。

- LIMIT:限制结果集返回的行数。例如,设置为5000行。

- OFFSET:指定结果集的起始位置。例如,从第21行开始。

这些参数可以在元数据配置中定义如下:

{

"field": "limit",

"label": "限制结果集返回的行数",

...

},

{

"field": "offset",

...

}动态SQL语句构建

为了确保灵活性和可维护性,我们在主SQL语句中使用占位符,并通过参数绑定的方法进行动态赋值。这种方式不仅提高了查询语句的可读性,还增强了安全性,防止SQL注入攻击。

{

...

"otherRequest": [

{

...

"value":

`select * from refundorder_z where ModifyDate >= :ModifyDateBegin and ModifyDate <= :ModifyDateEnd limit :limit offset :offset`

}

]

}数据时间范围过滤

为了保证只获取到最新修改的数据,我们引入了时间范围过滤条件,即开始时间(ModifyDateBegin)和结束时间(ModifyDateEnd)。这些时间参数通常会动态生成,例如:

{{LAST_SYNC_TIME|datetime}}: 上次同步时间{{CURRENT_TIME|datetime}}: 当前时间

这两个参数确保我们只抓取在特定时间段内修改过的数据,提高了数据同步的效率。

实时监控与异常处理

轻易云平台提供了强大的实时监控和告警系统,可以实时跟踪每个数据集成任务的状态和性能。一旦发现异常情况,如网络故障或数据库连接问题,系统会自动触发告警并执行错误重试机制,以确保任务能够顺利完成。

此外,通过日志记录功能,可以详细记录每次API调用及其响应情况,为后续排查问题提供有力支持。

数据质量监控与自定义转换逻辑

在获取到原始数据后,可以利用平台提供的数据质量监控功能,对数据进行校验,及时发现并处理异常。同时,通过自定义转换逻辑,可以对原始数据进行必要的清洗、转换,以适应目标系统的数据结构要求。例如,将日期格式统一、字段名称映射等操作,都可以通过自定义脚本实现。

总结

通过上述步骤,我们成功地调用了源系统MySQL接口并进行了初步的数据加工处理。这一过程不仅确保了高效、安全地获取所需数据,还为后续的数据转换与写入奠定了坚实基础。在实际应用中,根据具体业务需求,还可以进一步优化查询策略、调整参数设置,以达到最佳效果。

集成平台生命周期的第二步:将源平台数据进行ETL转换并写入MySQLAPI接口

在数据集成过程中,ETL(Extract, Transform, Load)是至关重要的一环。本文重点探讨如何使用轻易云数据集成平台,将已经集成的源平台数据进行ETL转换,并最终写入目标平台MySQLAPI接口。

数据提取与清洗

首先,我们需要从源平台提取数据。轻易云数据集成平台支持多种异构系统的数据提取,可以通过配置相应的连接器实现对源系统数据的访问。在本案例中,我们假设已经完成了数据提取和初步清洗工作,接下来重点关注数据转换和加载过程。

数据转换

在将数据写入MySQLAPI接口之前,需要进行一系列的数据转换操作,以确保数据格式符合目标平台的要求。以下是一个典型的元数据配置示例:

{

"api": "batchexecute",

"effect": "EXECUTE",

"method": "SQL",

"idCheck": true,

"request": [

{"field":"Id","label":"Id","type":"int","value":"{Id}"},

{"field":"Code","label":"Code","type":"string","value":"{Code}"},

{"field":"CreateDate","label":"CreateDate","type":"datetime","value":"{CreateDate}","default":"1970-01-01 00:00:00"},

// ... 其他字段配置

],

"otherRequest": [

{"field":"main_sql","label":"主语句","type":"string","value":"REPLACE INTO refundorder (Id,Code,CreateDate,...) VALUES"},

{"field":"limit","label":"limit","type":"string","value":"1000"}

],

"buildModel": true

}通过上述配置,我们定义了各个字段在目标表中的映射关系,并指定了默认值。例如,CreateDate字段如果为空,将默认设置为1970-01-01 00:00:00。这些转换逻辑可以通过轻易云的数据流设计工具进行可视化配置,使得整个过程更加直观。

数据加载

在完成数据转换后,下一步是将数据加载到目标平台MySQL。这里我们采用批量执行的方式,通过MySQLAPI接口实现高效的数据写入。

高吞吐量的数据写入能力:轻易云提供了高吞吐量的数据写入能力,使得大量数据能够快速被集成到MySQL系统中。这一点对于处理大规模退款单表(refundorder)的场景尤为重要。

定时可靠的数据抓取:为了确保集成过程中的稳定性和可靠性,可以设置定时任务定期抓取源系统的数据,并进行增量更新。这不仅提高了数据处理的效率,还确保了数据的一致性。

批量集成与分页处理:在实际操作中,为了避免一次性处理过多数据导致系统性能下降,可以采用分页处理机制。通过设置合理的分页大小(如每次处理1000条记录),可以有效控制单次请求的数据量,从而提高系统的稳定性。

REPLACE INTO refundorder (Id, Code, CreateDate, ...) VALUES (?, ?, ?, ...)上述SQL语句通过批量执行,将转换后的数据逐条插入或更新到目标表中。这里使用REPLACE INTO语法,可以实现插入或更新操作,从而避免重复记录的问题。

数据质量监控与异常处理

为了确保数据集成过程中的准确性和完整性,轻易云提供了强大的数据质量监控和异常检测功能。实时监控每个任务的执行状态,一旦发现异常情况,可以及时采取措施,如重试机制、告警通知等。

错误重试机制:在遇到网络波动或数据库锁等问题时,系统会自动重试失败的操作,确保最终一致性。这对于关键业务场景,如退款单表的处理尤为重要。

实时监控与日志记录

最后,通过轻易云的平台,可以实现对整个ETL过程的实时监控与日志记录。每一步操作都会生成详细的日志信息,方便后续追踪和审计。这不仅提升了运维效率,还为问题排查提供了有力支持。

综上所述,通过合理配置元数据和利用轻易云提供的各种特性,我们可以高效地将源平台的数据进行ETL转换,并最终无缝写入目标平台MySQLAPI接口。这不仅提升了业务透明度和效率,还保障了数据的一致性和完整性。