领星ERP与用友U8的高效数据集成方案

在企业管理系统中,数据的无缝对接和高效流转是实现业务流程自动化的关键。本文将分享一个实际案例:如何通过轻易云数据集成平台,将领星ERP中的FBA调拨出库数据集成到用友U8的其他出库模块。

案例背景

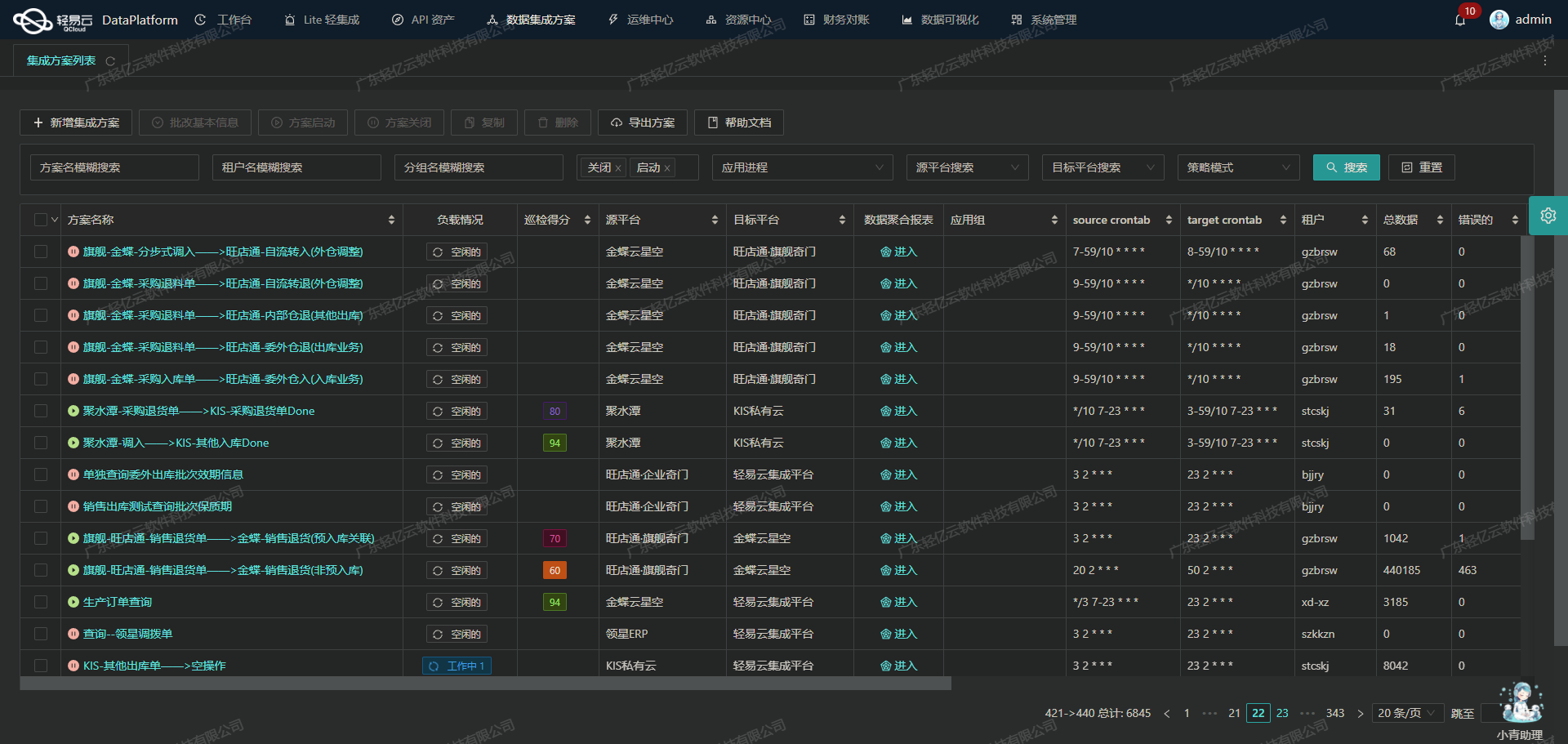

本次集成任务旨在实现领星ERP系统中的FBA调拨出库数据与用友U8系统中其他出库模块的数据同步。具体方案名称为“领星-FBA调拨出库-->U8-其他出库【其他出库】”。通过这一集成,我们能够确保两大系统之间的数据一致性和实时性,从而提升整体业务处理效率。

技术要点

-

高吞吐量的数据写入能力: 在本次集成过程中,我们需要处理大量的FBA调拨出库数据。这要求我们具备高吞吐量的数据写入能力,以确保这些数据能够快速且准确地被写入到用友U8系统中。

-

集中监控和告警系统: 为了实时跟踪数据集成任务的状态和性能,我们利用了轻易云平台提供的集中监控和告警系统。这不仅帮助我们及时发现并解决潜在问题,还能确保整个数据流动过程透明可视。

-

自定义数据转换逻辑: 由于领星ERP与用友U8之间存在一定的数据格式差异,我们设计了自定义的数据转换逻辑,以适应特定的业务需求和数据结构。这一步骤至关重要,确保了不同系统间的数据兼容性。

-

API接口调用: 数据获取方面,通过调用领星ERP提供的API接口

/cost/center/api/cost/stream,我们能够定时可靠地抓取所需的数据。而在目标平台,用友U8则通过其API接口/apilink/u8api接收并处理这些数据,实现批量集成。 -

异常处理与错误重试机制: 在实际操作中,不可避免会遇到各种异常情况。为了保证数据不漏单,我们设计了一套完善的异常处理与错误重试机制,确保每一条记录都能成功传输并写入到目标系统中。

通过上述技术手段,本次“领星-FBA调拨出库-->U8-其他出库【其他出库】”方案不仅实现了两个系统间的数据无缝对接,还极大提升了业务流程的自动化程度。在后续章节中,我们将详细探讨具体实施步骤及技术细节。

调用领星ERP接口/cost/center/api/cost/stream获取并加工数据

在轻易云数据集成平台的生命周期中,调用源系统接口是至关重要的一步。本文将详细探讨如何通过调用领星ERP接口/cost/center/api/cost/stream来获取并加工数据,以实现FBA调拨出库到U8其他出库的集成方案。

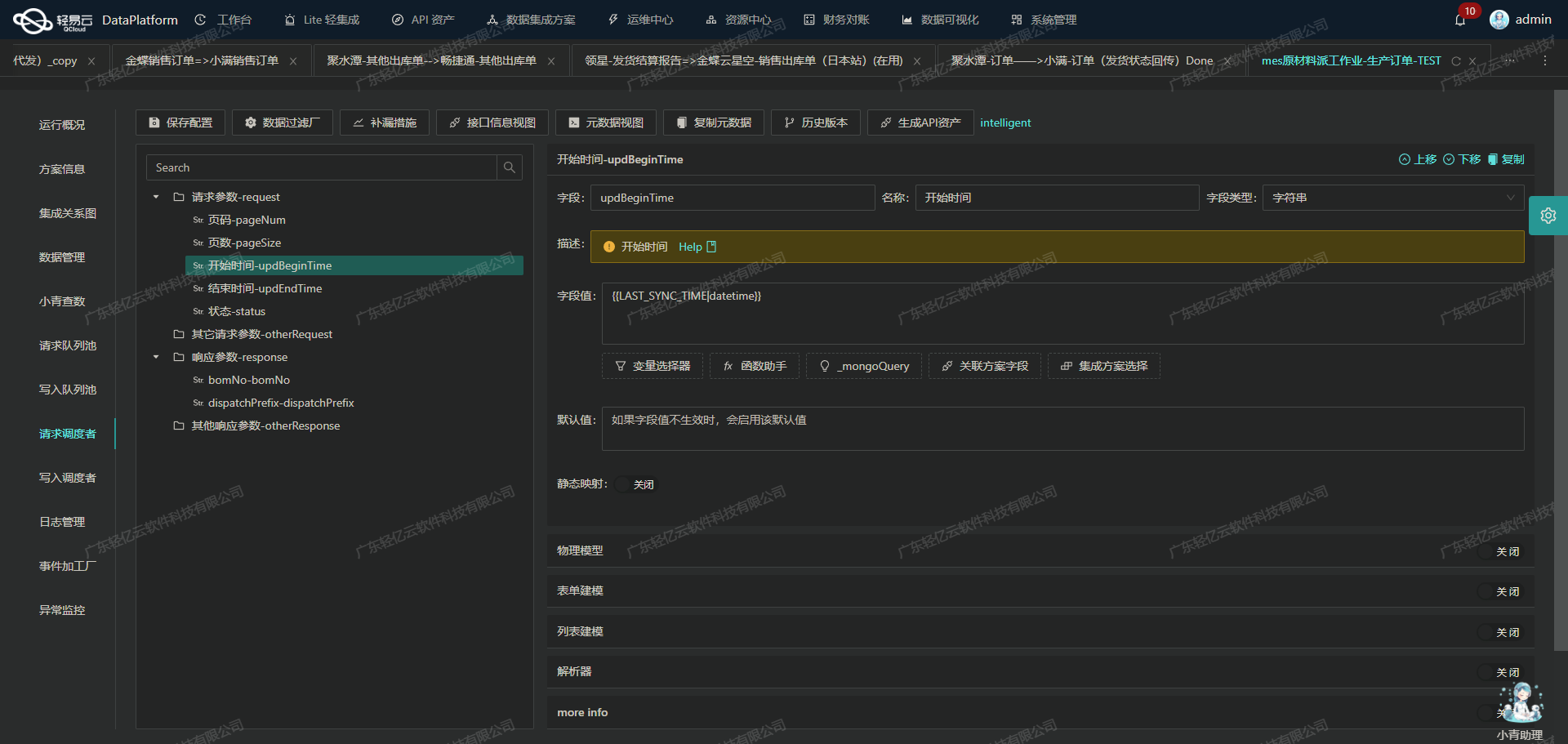

接口配置与请求参数

首先,我们需要配置元数据以便正确调用领星ERP的API。以下是关键的元数据配置:

{

"api": "/cost/center/api/cost/stream",

"effect": "QUERY",

"method": "POST",

"number": "business_number",

"id": "unique_key",

"name": "wo_number",

...

}该配置定义了API的基本信息,包括请求方法(POST)、主要字段(如业务编号、唯一键等)以及请求参数。

请求参数解析

为了确保我们能够准确地获取所需的数据,需要对请求参数进行详细解析和处理。以下是一些关键字段及其解析方式:

- 仓库名 (wh_names): 使用逗号分隔的字符串表示多个仓库名,通过

StringToArray解析器转换为数组。 - 店铺名 (shop_names): 类似于仓库名,也使用逗号分隔,并通过相同的解析器处理。

- SKU (skus) 和 MSKU (mskus): 同样采用逗号分隔字符串,并使用

StringToArray解析器。 - 库存属性 (disposition_types): 表示不同类型的库存属性,如可用在途、次品等,通过描述和数值对应关系进行转换。

- 出入库类型 (business_types): 包含多种业务类型,如调拨出库、盘点出库等,通过描述和数值对应关系进行转换。

例如,库存属性字段可以这样定义:

{

"field": "disposition_types",

"label": "库存属性",

...

}数据抓取与分页处理

由于API返回的数据量可能较大,我们需要考虑分页处理。默认情况下,每页返回200条记录,可以通过设置offset和length参数来控制分页。

{

"field": "offset",

...

},

{

"field": "length",

...

}在实际操作中,可以根据需求调整这两个参数,以确保高效抓取数据。例如,初始偏移量为1,每页长度为200条记录。

数据清洗与转换

获取到原始数据后,需要对其进行清洗和转换,以适应目标系统(如U8)的要求。这包括但不限于:

- 格式转换:将日期格式从Y-m-d转换为目标系统所需格式。

- 字段映射:将源系统中的字段映射到目标系统中的相应字段,例如,将“业务编号”映射为U8中的“单据编号”。

- 异常处理:检测并处理异常数据,例如缺失值或不符合预期的数据类型。

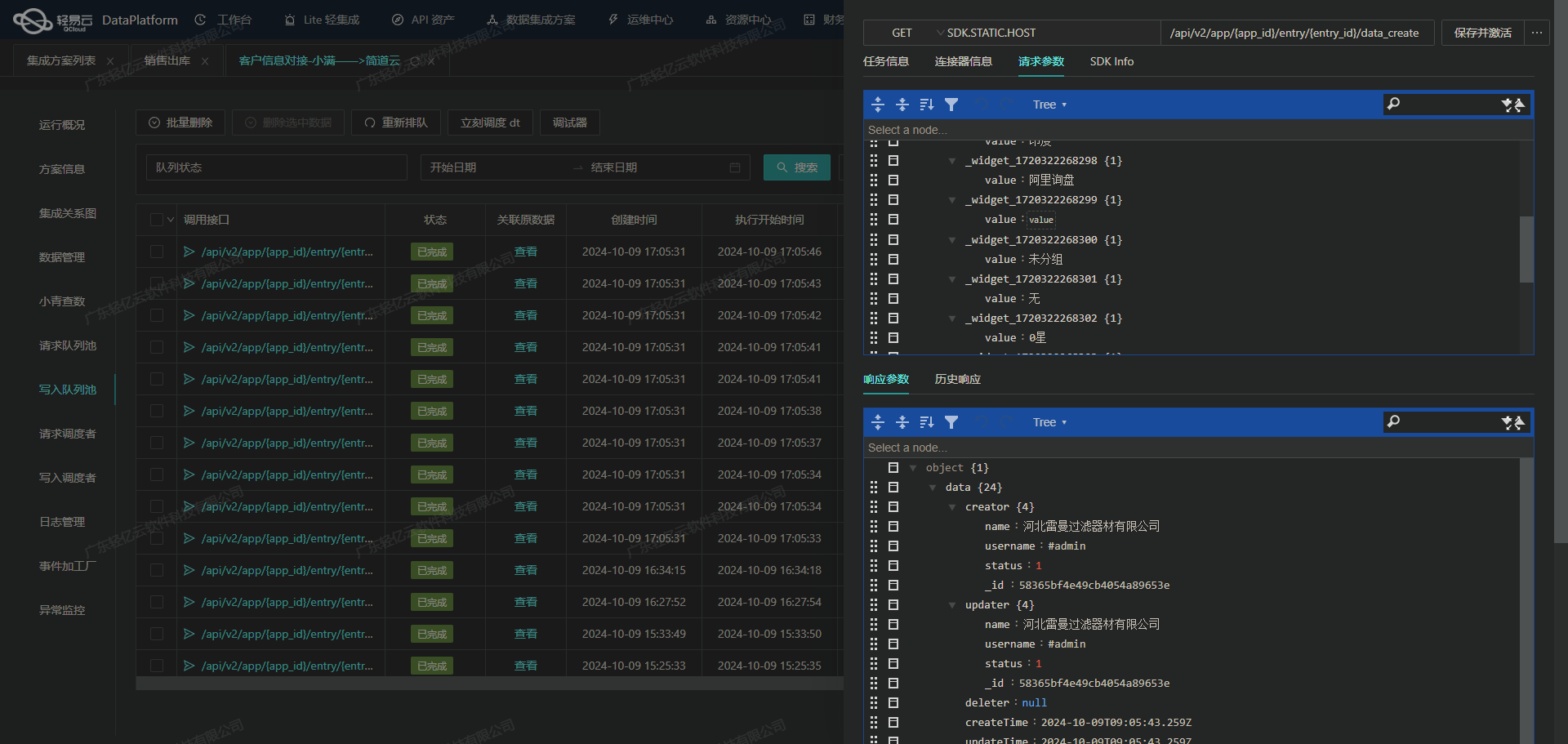

实时监控与日志记录

为了确保整个过程透明且可追溯,轻易云平台提供了实时监控和日志记录功能。这些功能允许我们实时跟踪每个数据集成任务的状态,并在出现问题时及时告警。例如,当某个批次的数据抓取失败时,可以自动触发重试机制或发送告警通知。

自定义逻辑与扩展性

轻易云平台支持自定义数据转换逻辑,这使得我们可以根据具体业务需求灵活调整。例如,对于特定业务场景下的数据,可以编写自定义脚本来实现复杂的数据清洗和转换操作,从而更好地满足企业需求。

综上所述,通过合理配置元数据、精确解析请求参数、有效处理分页及异常情况,以及利用平台提供的实时监控和自定义逻辑功能,我们可以高效地完成从领星ERP到U8其他出库的数据集成任务。这不仅提升了数据处理效率,还确保了整个过程的透明度和可靠性。

用友U8API接口数据集成与ETL转换案例

在数据集成过程中,ETL(Extract, Transform, Load)是关键的一步,尤其是在将领星ERP系统的数据转换为用友U8API接口所能接收的格式,并最终写入目标平台时。以下是一个详细的技术案例,展示如何通过轻易云数据集成平台实现这一过程。

数据请求与清洗

在进行ETL转换之前,我们首先需要从领星ERP系统中提取相关数据。假设我们已经成功从领星ERP接口/cost/center/api/cost/stream中获取了所需的数据,这些数据包括单据头和单据体信息。

数据转换逻辑

接下来,我们需要将这些提取到的数据进行清洗和转换,以符合用友U8API接口的要求。以下是一些关键的转换步骤:

-

字段映射与合并:

- 将领星ERP中的字段映射到用友U8API接口所需的字段。例如,将

wh_name映射为仓库名称,将shop_name映射为业务员和客户。 - 合并多个字段以生成目标平台所需的复杂对象结构。例如,将单据体中的多行商品信息合并为一个数组。

- 将领星ERP中的字段映射到用友U8API接口所需的字段。例如,将

-

自定义转换逻辑:

- 使用自定义函数处理特殊字段。例如,使用CASE语句将特定仓库名称进行转换:

_function CASE '{wh_name}' WHEN 'DTECH Multimedia-IN印度仓' THEN 'DT-IN印度仓' ELSE '{wh_name}' END - 对数量字段进行绝对值处理,以确保正负数问题不会影响数据写入:

_function ABS( {change_quantity} )

- 使用自定义函数处理特殊字段。例如,使用CASE语句将特定仓库名称进行转换:

-

数据质量监控:

- 在数据转换过程中,实时监控数据质量,检测异常情况并及时处理。例如,通过日志记录和告警系统跟踪每一条数据的处理状态,确保所有数据都能正确转换和写入。

数据写入目标平台

经过上述步骤的清洗和转换后,数据已经准备好写入用友U8API接口。以下是如何配置元数据以实现这一目标:

{

"api": "/apilink/u8api",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true,

"operation": {

"method": "merge",

"field": "wh_name",

"bodySum": ["change_quantity"],

"bodyName": "goods_list",

"header": ["wh_name", "shop_name"],

"body": ["sku", "change_quantity"]

},

...

}- API调用配置:指定调用用友U8API接口的方法(POST),并设置必要的参数,如是否进行ID检查等。

- 操作配置:定义如何合并和计算字段,例如对

change_quantity求和,并将其放入goods_list中。 - 请求参数配置:根据目标平台要求设置具体请求参数,包括单据头和单据体的信息。

异常处理与重试机制

在实际操作中,不可避免会遇到各种异常情况,例如网络故障或接口响应错误。为了确保数据能够可靠地写入,我们需要实现异常处理与重试机制:

- 实时监控与告警:通过集中的监控系统实时跟踪每个数据集成任务的状态,一旦发现异常立即触发告警。

- 错误重试机制:对于失败的数据写入操作,自动进行重试,确保最终成功。例如,可以设置重试次数和间隔时间,以平衡效率和稳定性。

批量处理与高效写入

为了提高大规模数据集成的效率,可以采用批量处理方式,将多条记录一次性写入用友U8系统。这不仅减少了网络请求次数,还能显著提升整体性能。

总结以上步骤,通过轻易云数据集成平台,我们能够高效地完成从领星ERP到用友U8API接口的数据ETL转换与写入过程。这一流程确保了不同系统之间的数据无缝对接,同时保持了高质量、高效率的数据处理能力。