钉钉数据集成到MySQL的技术案例分享

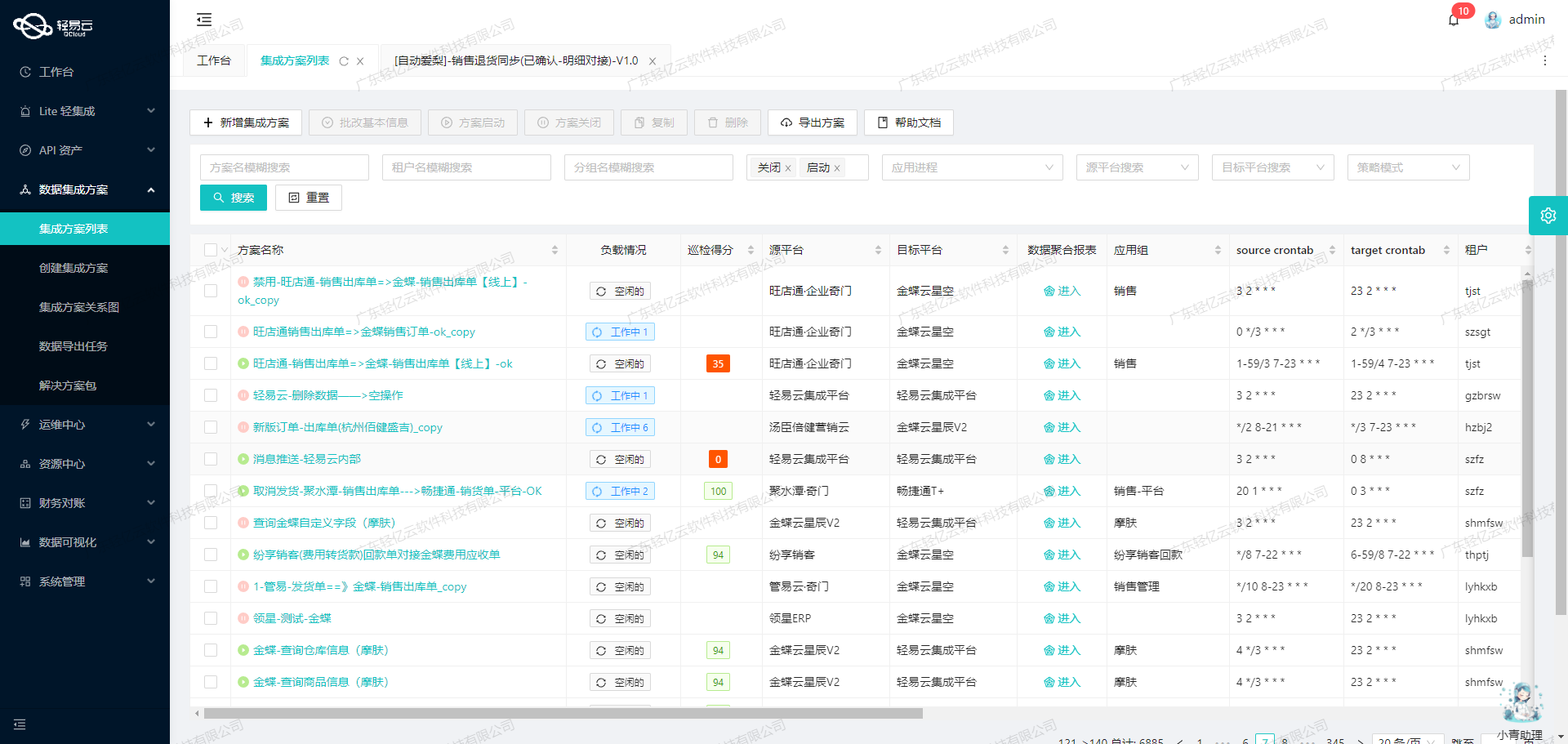

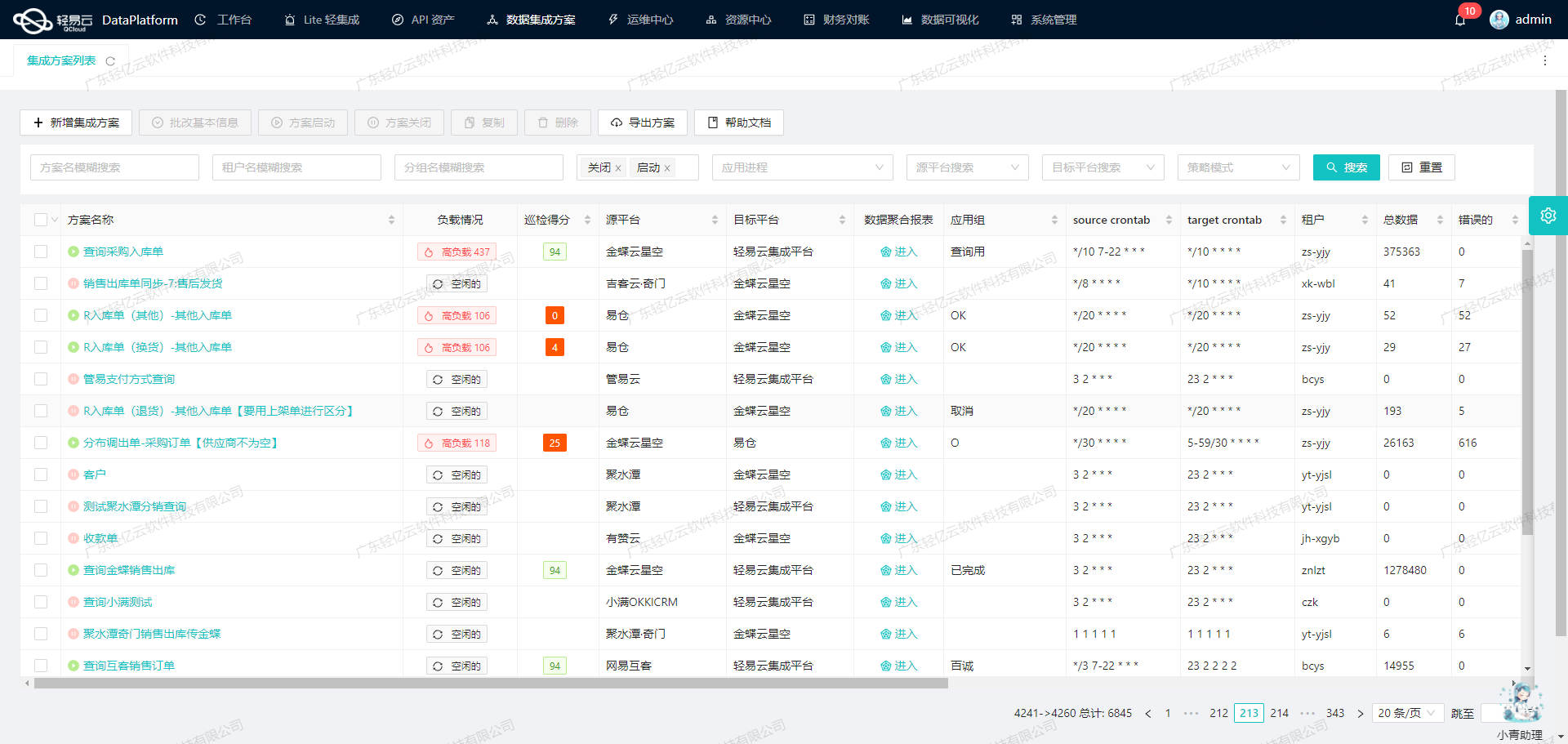

在企业信息化管理中,数据的高效集成和处理至关重要。本文将聚焦于一个具体的系统对接集成案例:如何将钉钉中的花名册数据集成到MySQL数据库中,实现BI崛起-花名册方案。

集成背景与挑战

在本次集成任务中,我们需要从钉钉获取员工在职信息,并将这些数据可靠地写入到MySQL数据库中,以便进行后续的数据分析和业务决策支持。主要面临的技术挑战包括:

- 高吞吐量的数据写入能力:确保大量数据能够快速被集成到MySQL系统中,提升数据处理的时效性。

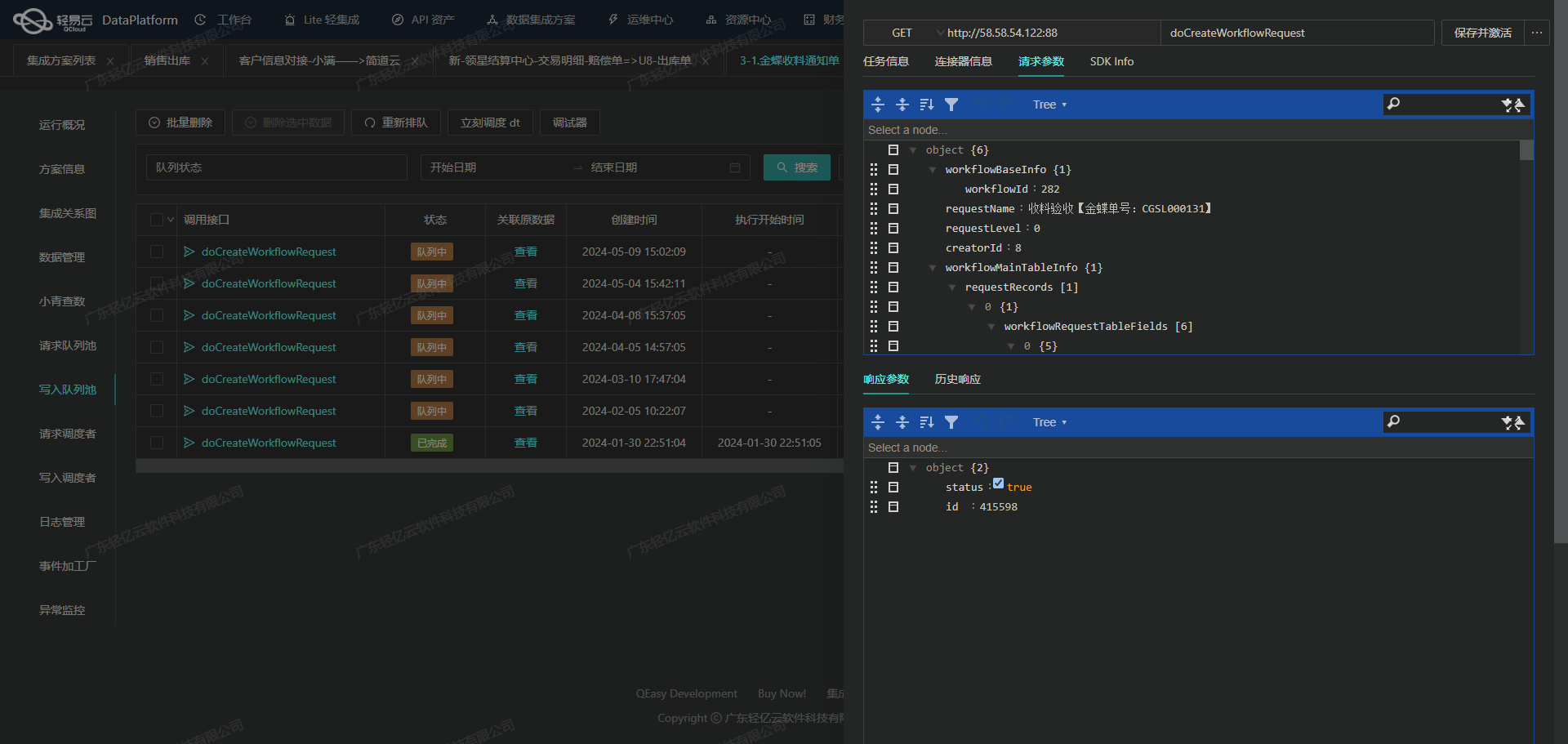

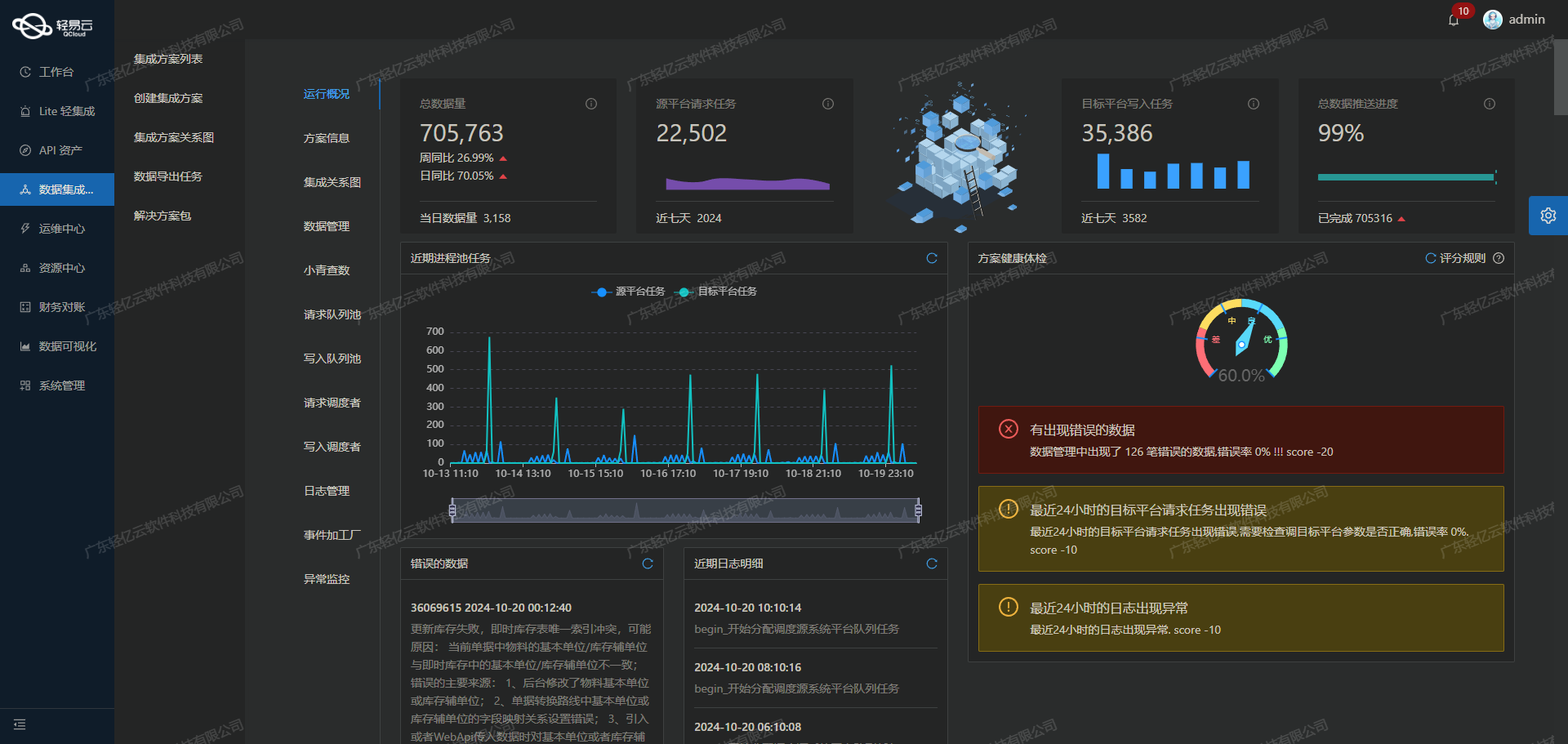

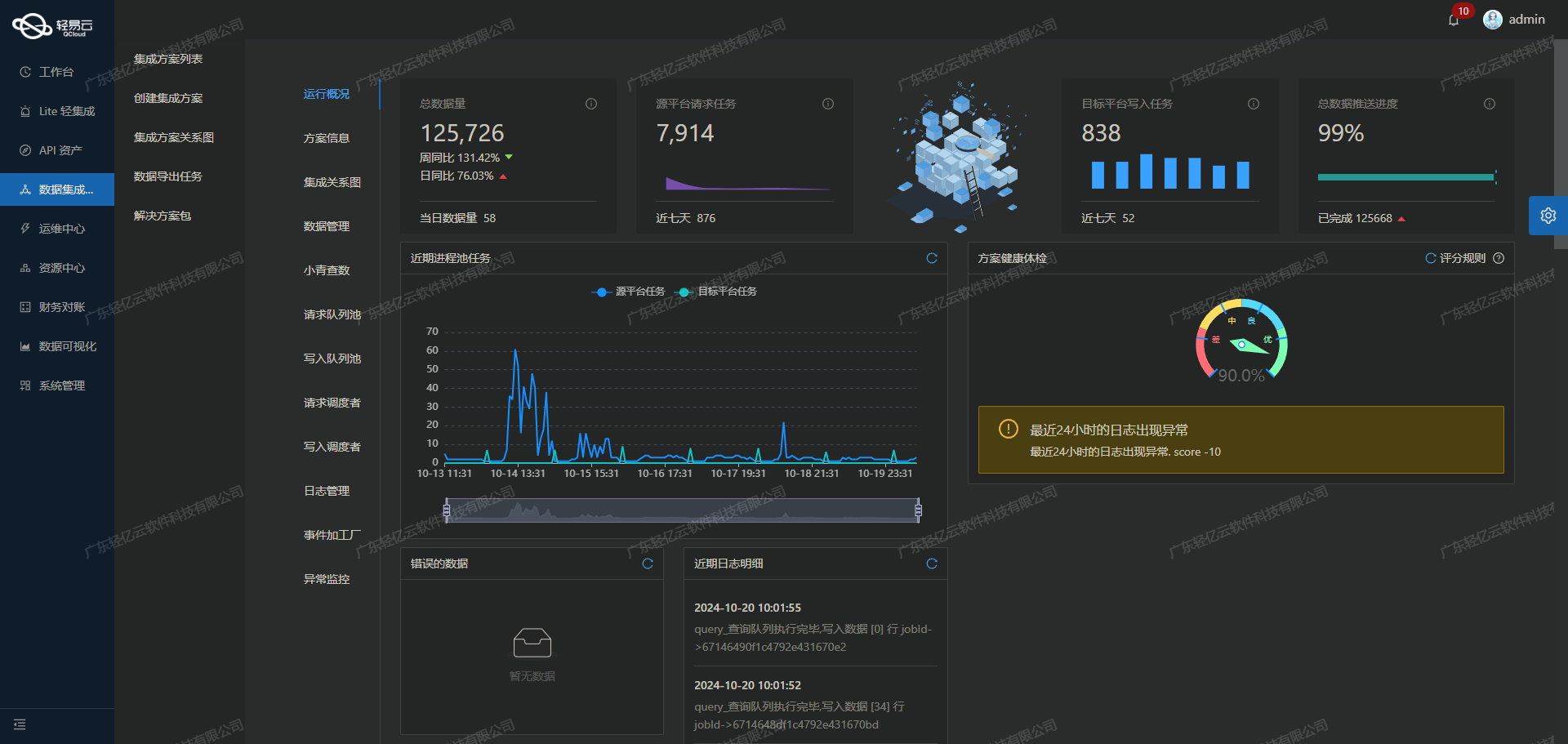

- 实时监控与告警:提供集中监控和告警系统,实时跟踪数据集成任务的状态和性能。

- API资产管理:通过统一视图和控制台,全面掌握API资产的使用情况,实现资源高效利用和优化配置。

- 数据质量监控与异常检测:及时发现并处理数据问题,确保数据准确性和完整性。

- 自定义数据转换逻辑:适应特定业务需求和数据结构,实现灵活的数据转换。

解决方案概述

为了实现上述目标,我们采用了以下关键步骤:

-

调用钉钉接口获取数据: 使用

topapi/smartwork/hrm/employee/queryonjob接口,从钉钉系统中抓取员工在职信息。该接口支持分页查询,可以有效处理大规模用户数据。 -

批量写入MySQL数据库: 利用MySQL的

executeAPI,将获取的数据批量写入数据库。这不仅提高了写入效率,还能减少网络传输带来的延迟。 -

处理分页与限流问题: 在调用钉钉API时,需要特别注意分页机制以及限流策略,以避免因请求过多导致接口调用失败或被限制。

-

格式差异与映射对接: 由于钉钉返回的数据格式可能与MySQL表结构不一致,我们通过自定义的数据转换逻辑,对字段进行映射和转换,确保两者兼容。

-

异常处理与重试机制: 在整个集成过程中,设计了完善的异常处理机制,包括错误日志记录、自动重试等功能,以保证任务执行的稳定性和可靠性。

-

实时监控与日志记录: 实现了对整个数据处理过程的实时监控,并详细记录每一步操作日志,为后续问题排查提供依据。

通过以上步骤,我们成功实现了从钉钉到MySQL的数据无缝对接,为企业提供了一套高效、可靠的数据管理解决方案。在接下来的章节中,我们将详细介绍每个步骤中的具体实现方法及技术细节。

调用钉钉接口topapi/smartwork/hrm/employee/queryonjob获取并加工数据

在数据集成过程中,调用源系统的API接口是关键的一步。本文将详细探讨如何通过轻易云数据集成平台调用钉钉接口topapi/smartwork/hrm/employee/queryonjob来获取在职员工信息,并进行初步的数据加工处理。

接口配置与请求参数

首先,我们需要配置元数据,以便正确地调用钉钉接口。以下是主要的元数据配置项:

- API路径:

topapi/smartwork/hrm/employee/queryonjob - 请求方法:POST

- 分页参数:

offset:分页游标,用于控制从哪一条记录开始读取。size:每页返回的记录数,默认设置为50。

- 状态筛选:通过

status_list字段筛选在职员工状态,值为"2,3,5,-1"。

{

"api": "topapi/smartwork/hrm/employee/queryonjob",

"method": "POST",

"request": [

{"field": "status_list", "value": "2,3,5,-1"},

{"field": "offset", "type": "int"},

{"field": "size", "type": "int", "value": 50}

]

}数据抓取与分页处理

由于可能存在大量在职员工数据,需要实现分页抓取。每次请求时,通过调整offset和size参数来获取不同页的数据。

-

初始化请求:

- 设置初始的

offset=0,size=50. - 发起第一次API请求以获取第一页的数据。

- 设置初始的

-

循环抓取:

- 检查返回结果中的总记录数和当前已抓取的记录数。

- 如果未抓取完所有记录,则增加

offset, 再次发起API请求。 - 重复上述步骤直到所有数据被抓取完毕。

数据清洗与转换

从钉钉接口获取到原始数据后,需要对其进行清洗和转换,以适应目标系统(如BI崛起)的需求。以下是一些常见的数据处理步骤:

-

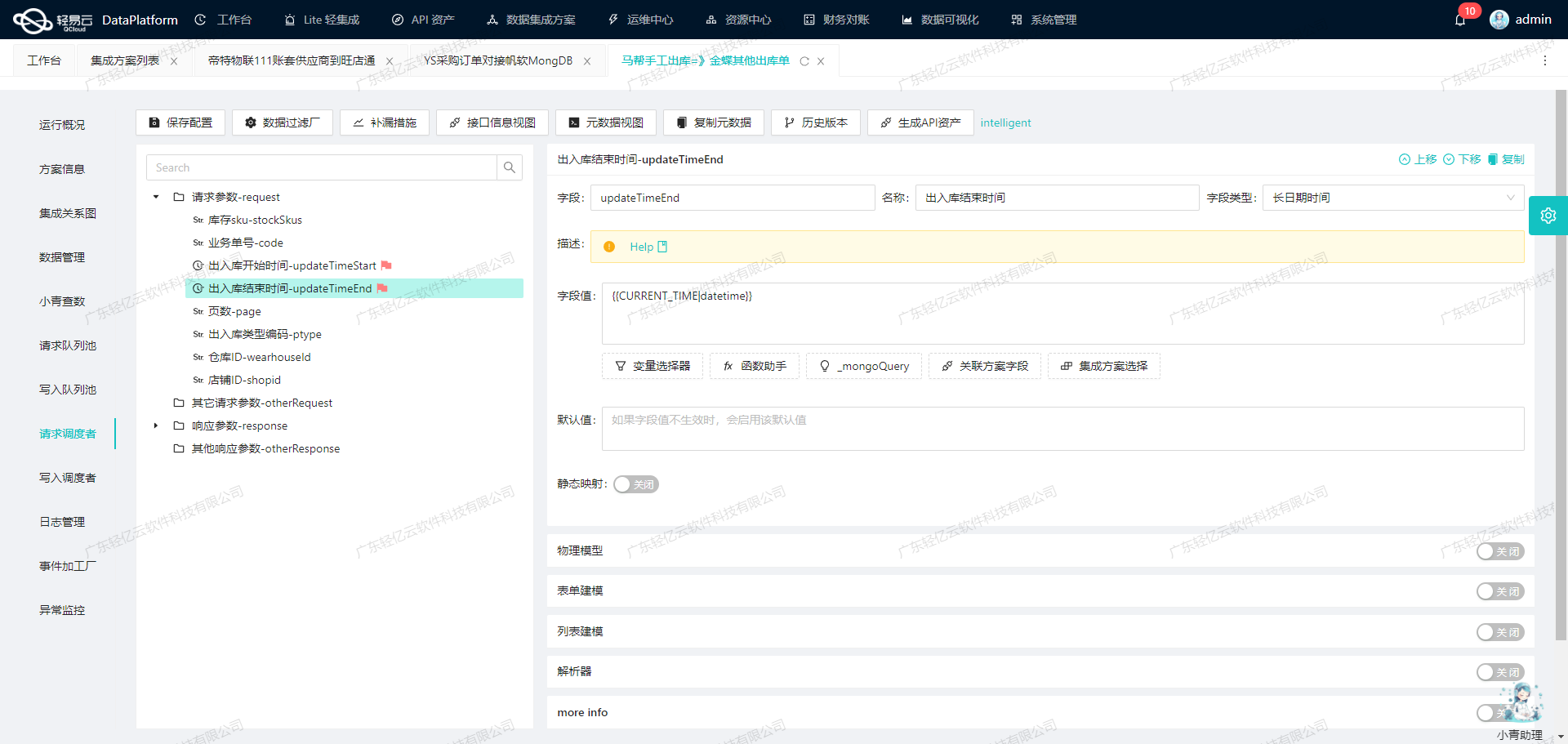

字段映射与重命名: 根据业务需求,将原始字段映射到目标字段。例如,将“姓名”映射为“name”,“邮箱”映射为“email”。

-

格式转换: 对日期、时间等特殊格式的数据进行转换。例如,将日期字符串转换为标准的ISO格式。

-

缺失值处理: 对于缺失或异常值进行填充或剔除,以确保数据质量。例如,对于缺失的手机号,可以填充默认值或标记为空。

-

自定义逻辑应用: 根据具体业务需求,应用自定义的逻辑对某些字段进行计算或变换。例如,根据入职时间计算员工司龄,并添加到结果集中。

实时监控与日志记录

为了确保整个过程顺利进行,轻易云平台提供了实时监控和日志记录功能。这些功能可以帮助我们及时发现并解决问题,提高整体效率和可靠性。

-

实时监控:通过可视化界面实时查看各个任务的执行状态,包括成功率、错误率等关键指标。

-

日志记录:详细记录每次API调用及其响应情况,包括请求参数、返回结果、错误信息等。这些日志对于排查问题和优化流程非常有帮助。

异常处理与重试机制

在实际操作中,不可避免会遇到各种异常情况,如网络超时、接口限流等。为了提高系统稳定性,需要设计合理的异常处理和重试机制:

-

限流保护: 针对钉钉接口可能存在的限流限制,可以设置合理的重试间隔时间,并采用指数退避算法逐步增加重试间隔,以减少对服务器压力。

-

错误重试: 对于临时性错误(如网络超时),可以设置自动重试机制,在一定次数内尝试重新发送请求。如果多次尝试仍失败,则记录错误并通知相关人员进行人工干预。

通过以上步骤,我们能够高效地调用钉钉接口获取在职员工信息,并完成初步的数据清洗和转换,为后续的数据写入和分析打下坚实基础。在整个过程中,轻易云平台提供了强大的支持,使得复杂的数据集成任务变得更加简洁高效。

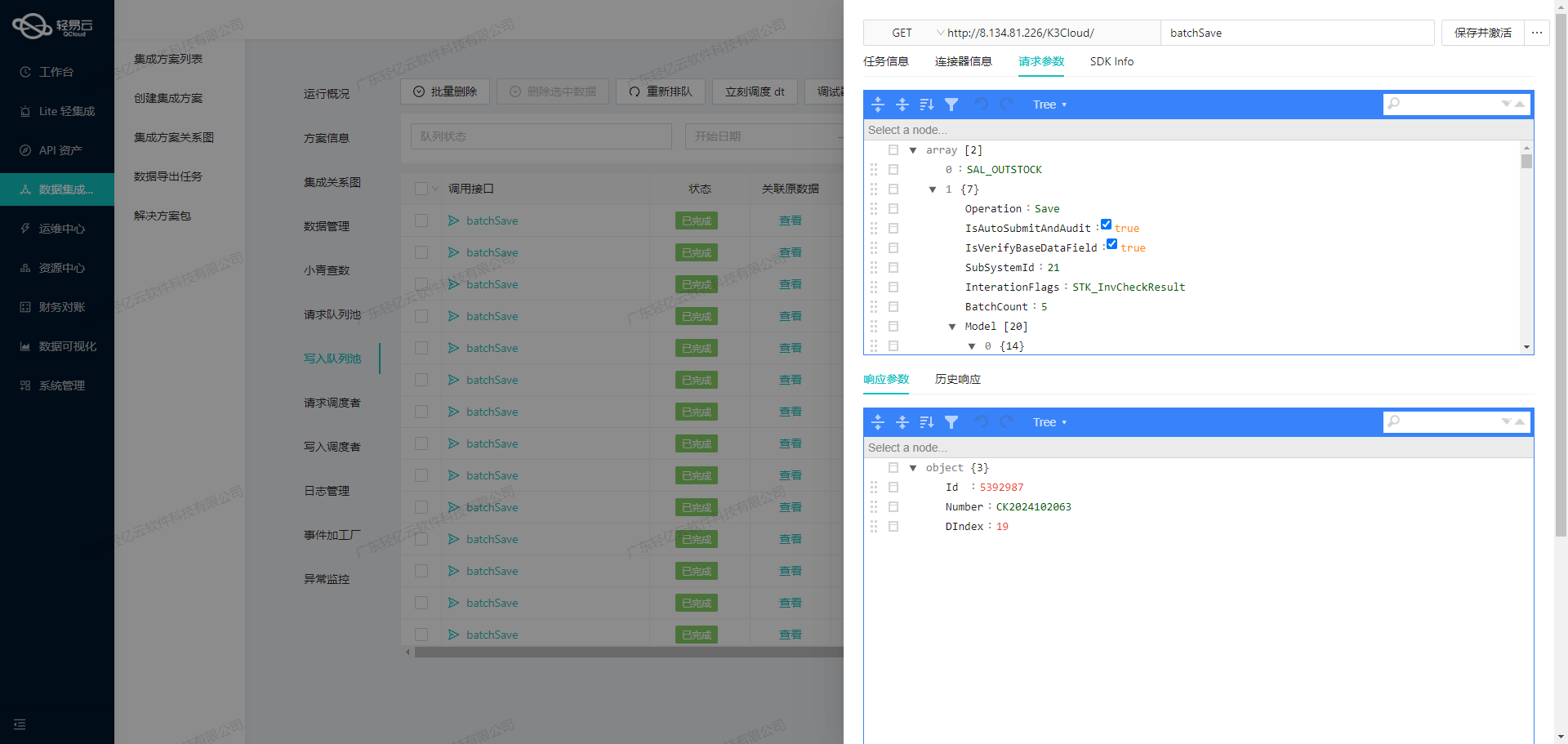

数据ETL转换与写入MySQLAPI接口

在数据集成生命周期的第二步中,关键任务是将从源平台(如钉钉)获取的数据进行ETL(提取、转换、加载)处理,并最终写入目标平台MySQL数据库。这个过程中涉及到数据格式的转换、数据清洗和数据写入操作。

1. 数据提取与转换

首先,从钉钉获取原始数据。调用钉钉接口topapi/smartwork/hrm/employee/queryonjob,确保抓取的数据完整且符合预期。由于钉钉接口通常会有分页和限流限制,我们需要处理这些问题以确保数据不漏单。

{

"api": "execute",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "main_params",

"label": "main_params",

"type": "object",

...

}

]

}2. 数据清洗与转换逻辑

提取到的数据可能包含冗余信息或格式不一致的问题,因此需要进行清洗和转换。比如,将日期格式统一为YYYY-MM-DD,将手机号格式化为国际标准等。这一步可以利用轻易云平台提供的自定义数据转换逻辑功能,根据业务需求对字段进行处理。

{

"field": "confirmJoinTime",

"label": "入职时间",

"type": "string",

"value": "{{入职时间_field_value_list_value}}"

}3. 构建SQL语句

在完成数据清洗和格式转换后,需要将数据映射到目标平台MySQL的表结构中。以下是一个示例SQL语句,用于将员工花名册信息插入到MySQL数据库中:

REPLACE INTO employee_roster (

userid, name, email, deptIds, mainDeptId, dept, mainDept, reportManager,

position, mobile, jobNumber, tel, workPlace, remark, confirmJoinTime,

entryAge, employeeType, employeeStatus, probationPeriodType, regularTime,

planRegularTime, probation_duration, positionLevel, probation_salary,

post_probation_salary, adjusted_salary, original_salary, cost_center,

realName, certNo, birthTime, age, sexType, nationType, certAddress,

certEndTime, marriage, joinWorkingTime, workAge,

address,

politicalStatus,

personalSi,

personalHf,

height,

weight,

physical_condition,

place_of,

email_or_qq,

home_phone,

overtime,

business_trip,

job_transfer,

salary_requirements,

recruitment_source,

available_date,

introducer,

labor_relation,

computer_level,

driver_license,

foreign_language_level,

other_language,chinese_level

) VALUES (

:userid,:name,:email,:deptIds,:mainDeptId,:dept,:mainDept,:reportManager,:position,:mobile,:jobNumber,:tel,:workPlace,:remark,:confirmJoinTime,:entryAge,:employeeType,:employeeStatus,:probationPeriodType,:regularTime,:planRegularTime,:probation_duration,:positionLevel,:probation_salary,:post_probation_salary,:adjusted_salary

);4. 数据写入MySQL

通过轻易云平台的高吞吐量数据写入能力,可以将大量清洗后的数据快速写入MySQL数据库。这一步需要确保事务的一致性和完整性,避免因网络或系统故障导致的数据丢失或重复。

5. 异常处理与监控

在整个ETL过程中,异常处理与监控至关重要。轻易云平台提供了集中的监控和告警系统,可以实时跟踪数据集成任务的状态和性能。例如,当出现网络异常或接口调用失败时,系统能够自动重试并记录日志,以便后续分析和排查。

通过以上步骤,成功实现了从钉钉花名册到BI崛起花名册的数据ETL转换,并将其无缝写入到目标平台MySQL数据库中。此过程不仅提高了数据处理的效率,还确保了数据的一致性和可靠性。