备货订单马帮数据集成到金蝶云星空案例分享

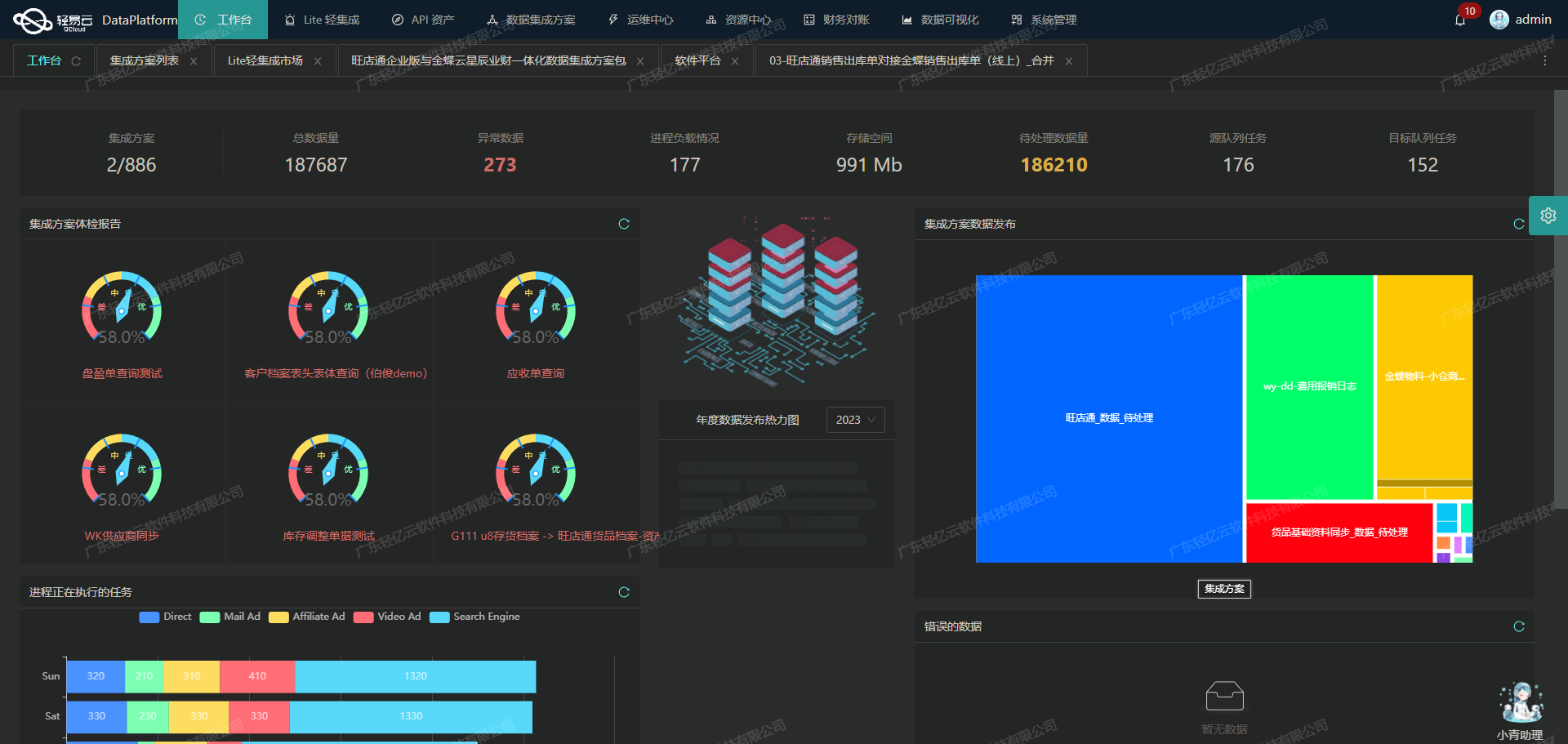

在本次技术案例中,我们将探讨如何通过轻易云数据集成平台,将马帮的备货订单数据高效、可靠地集成到金蝶云星空系统中。该方案已成功通过测试,确保了数据的完整性和实时性。

数据获取与处理

首先,通过调用马帮提供的API接口hwc-shippbatch-get-shipment-list,我们能够定时可靠地抓取备货订单数据。为了应对大规模的数据量,我们利用轻易云平台的高吞吐量数据写入能力,使得大量订单信息能够快速被处理并传输至目标系统。

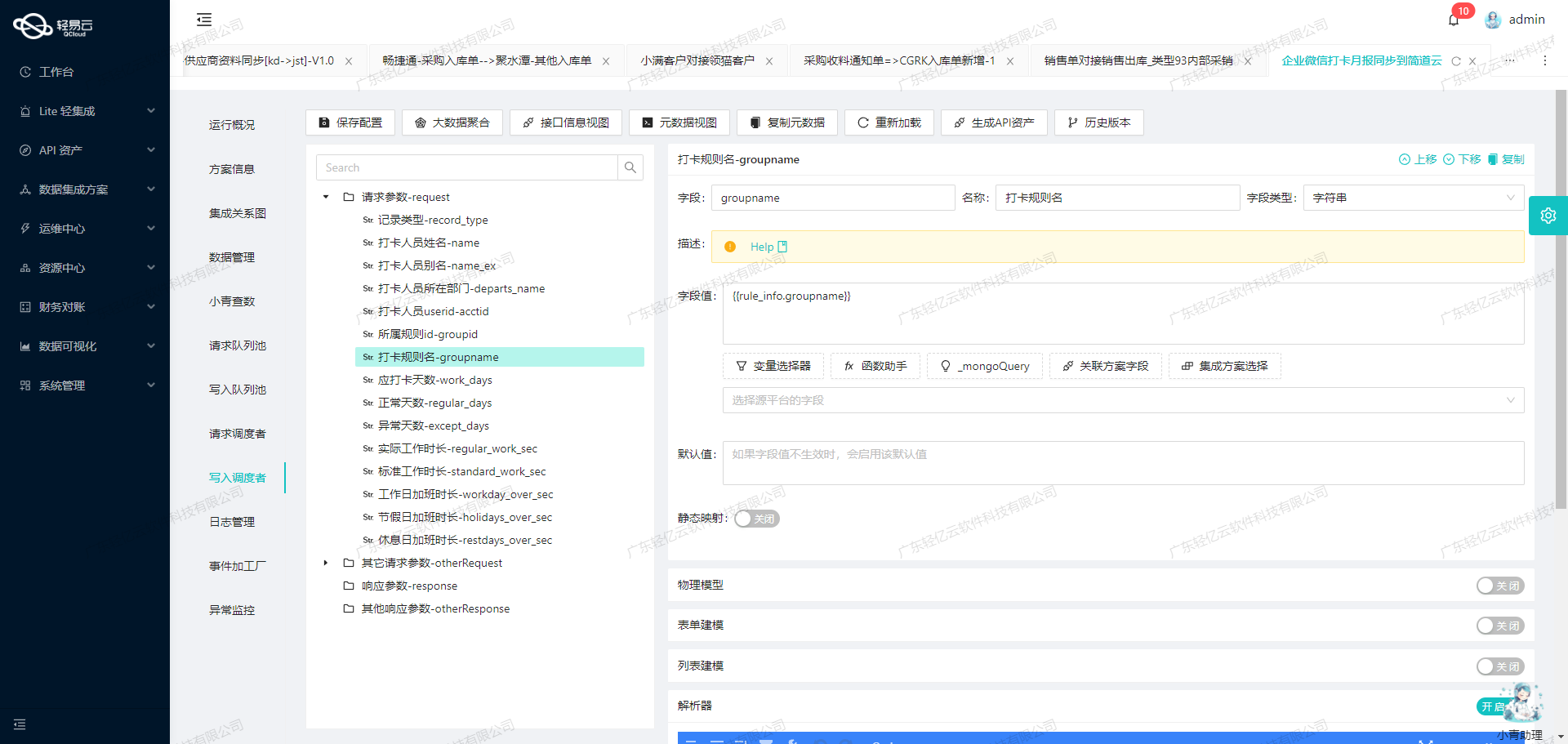

数据转换与映射

在数据流转过程中,不同系统之间的数据格式差异是一个常见挑战。为此,我们使用了自定义的数据转换逻辑,以适应特定业务需求和数据结构。同时,金蝶云星空提供了灵活的数据映射功能,使得复杂的数据对接变得更加简便。

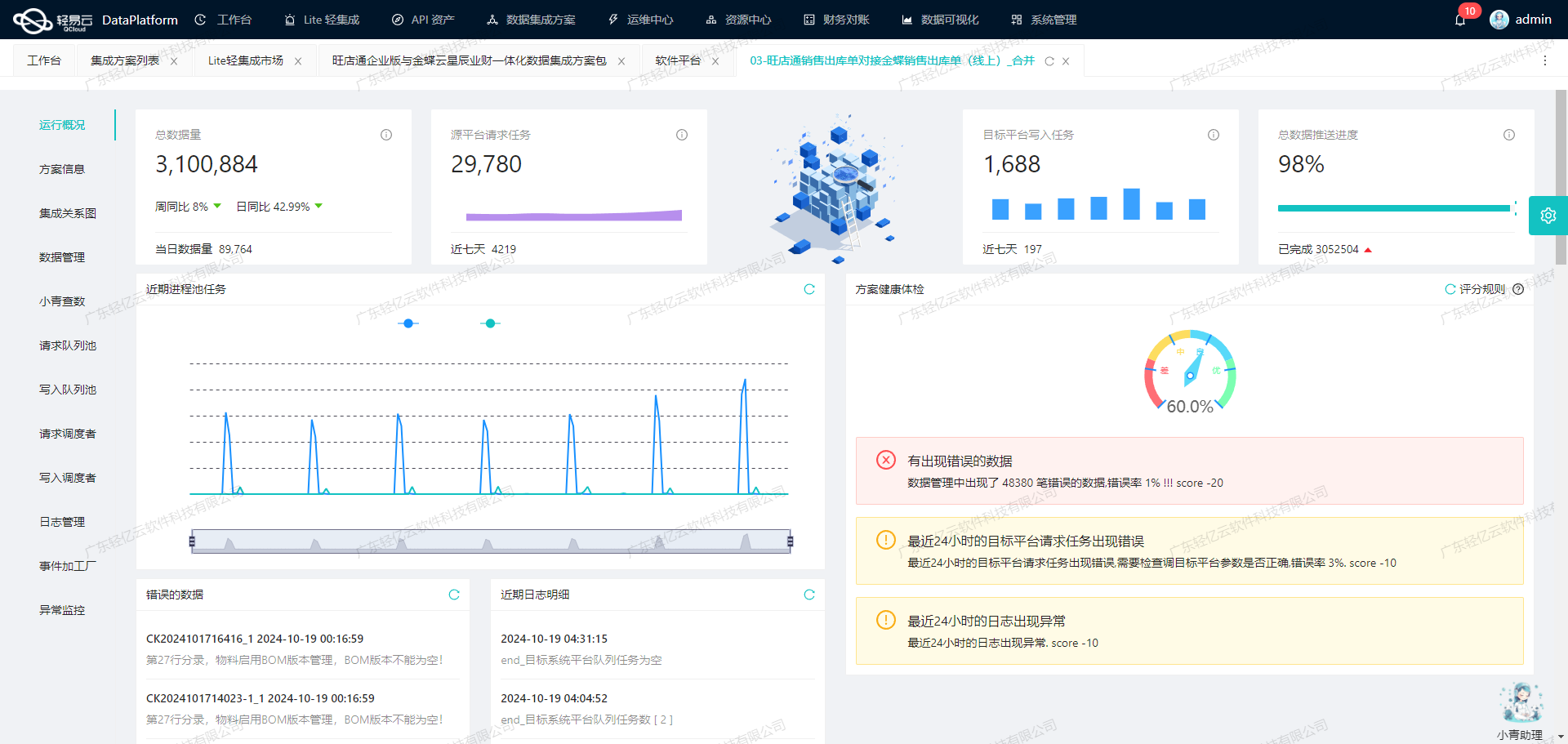

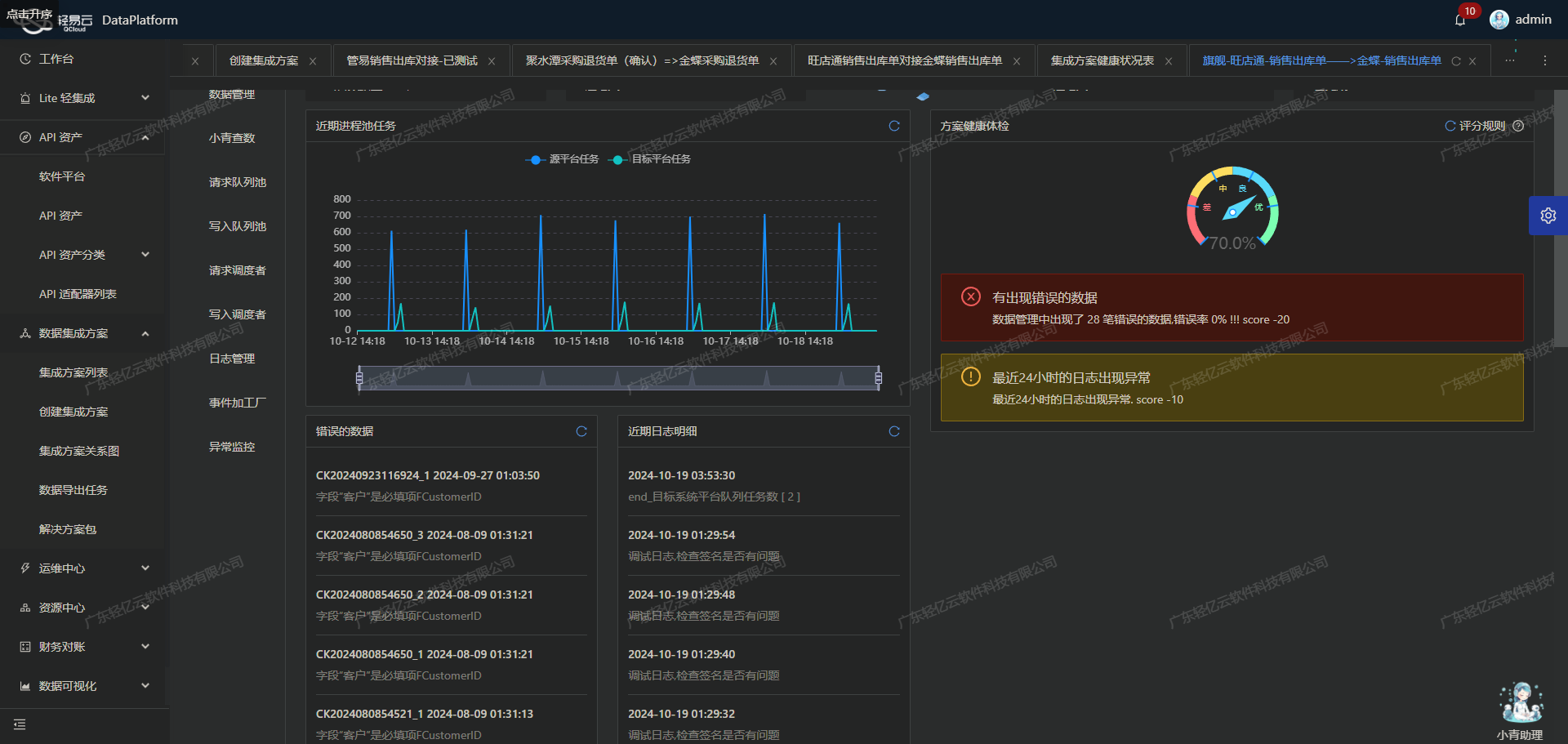

实时监控与异常处理

为了确保整个集成过程的稳定性和透明度,轻易云平台提供了集中监控和告警系统,实时跟踪每个任务的状态和性能。一旦出现异常情况,如接口限流或分页问题,系统会自动触发错误重试机制,并记录详细日志以供后续分析。

数据写入与优化

最终,通过调用金蝶云星空的batchSave API接口,我们实现了批量将处理后的订单数据写入目标系统。在这个过程中,为了避免漏单现象,我们设计了一套完善的数据质量监控体系,确保每一条订单都能准确无误地进入金蝶云星空。

以上是本次技术案例开头部分的概要介绍,在接下来的章节中,我们将深入探讨具体实现细节及技术要点。

调用马帮接口hwc-shippbatch-get-shipment-list获取并加工数据

在轻易云数据集成平台中,调用源系统接口是数据处理生命周期的第一步。本文将详细探讨如何通过调用马帮接口hwc-shippbatch-get-shipment-list来获取备货订单数据,并进行初步加工处理。

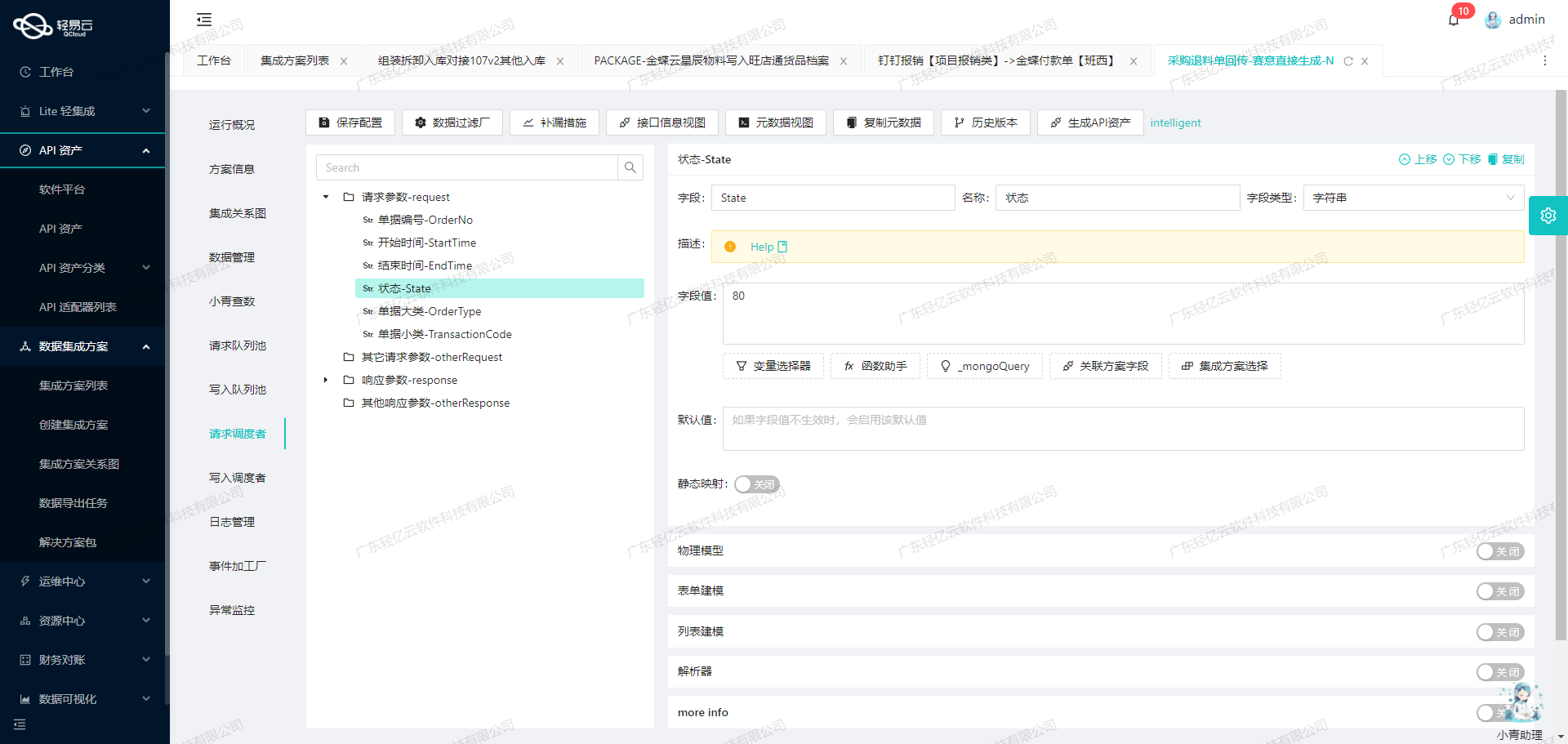

接口调用配置

首先,我们需要配置元数据以便正确调用马帮接口。以下是关键的元数据配置:

{

"api": "hwc-shippbatch-get-shipment-list",

"effect": "QUERY",

"method": "POST",

"number": "shipmentId",

"id": "id",

"name": "stockName",

...

}该配置指定了API名称、请求方法以及一些重要的字段映射关系,如shipmentId和stockName等。

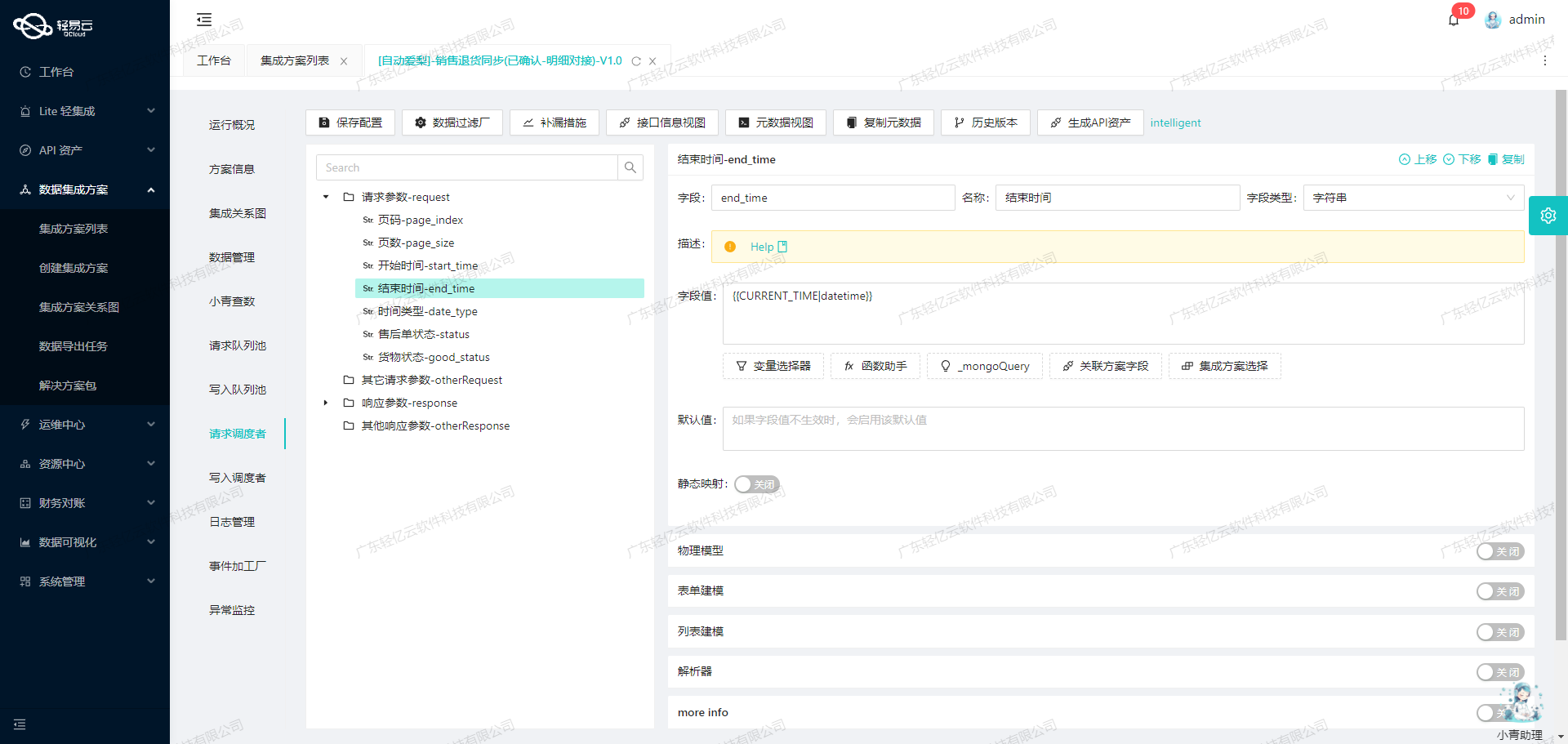

请求参数设置

为了确保我们能够准确地获取所需的数据,需要设置一系列请求参数。这些参数包括时间范围、状态、分页信息等:

timeLastModifiedStart: 更新开始时间,通常使用上次同步时间。timeLastModifiedEnd: 更新结束时间,通常使用当前时间。status: 数据状态,这里我们选择已发货状态(值为2)。page: 页数,从1开始。pageSize: 每页条目数,这里设为20。

这些参数可以通过以下方式进行配置:

{

"field": "timeLastModifiedStart",

...

},

{

"field": "timeLastModifiedEnd",

...

},

{

"field": "status",

...

},

{

"field": "page",

...

},

{

"field": "pageSize",

...

}数据清洗与转换

在获取到原始数据后,需要对其进行清洗和转换,以便后续处理。主要步骤包括:

-

过滤无效数据:根据条件过滤掉不符合要求的数据,例如只保留状态为“已发货”且交付数量大于0的记录。

{ "condition_bk":[ [ {"field":"ShipmentStatus","logic":"in","value":"SHIPPED,IN_TRANSIT"}, {"field":"itemList.deliveryQuantity","logic":"gt","value":"0"} ] ] } -

字段映射:将原始字段映射到目标系统所需的字段。例如,将

shipmentId映射到目标系统中的唯一标识符。 -

格式转换:根据目标系统的要求,对日期、数字等字段进行格式转换。例如,将UNIX时间戳转换为标准日期格式。

异常处理与重试机制

在实际操作中,可能会遇到各种异常情况,如网络超时、API限流等。为了确保数据集成过程的可靠性,需要实现异常处理与重试机制:

-

限流控制:针对API限流问题,可以通过调整请求频率或引入延迟来避免触发限流限制。

-

错误重试:对于临时性错误,可以设置自动重试机制,在一定次数内尝试重新发送请求。

-

日志记录:实时记录每次请求和响应的信息,以便后续排查问题。这有助于快速定位并解决潜在的问题,提高整体稳定性。

定时任务与监控

为了确保数据集成过程的持续性和稳定性,可以设置定时任务定期抓取马帮接口的数据,并通过集中监控系统实时跟踪任务状态和性能:

{

crontab: '20 */6 * * *',

takeOverRequest: [

{

field: 'expressTimeStart',

label: '修改时间开始段',

type: 'string',

is_required: true,

value: '_function FROM_UNIXTIME( unix_timestamp() -21600 , \'%Y-%m-%d %H:%i:%s\' )'

}

]

}这种方式不仅能保证数据及时更新,还能有效防止漏单现象发生。

综上,通过合理配置元数据、精确设置请求参数、实施有效的数据清洗与转换策略,以及完善的异常处理与监控机制,可以高效完成从马帮接口获取并加工备货订单数据,为后续的数据写入奠定坚实基础。

集成方案:备货订单马帮至金蝶云星空的ETL转换与数据写入

在集成过程中,第二步是将已经从源平台(如马帮)提取的数据进行ETL转换,转化为目标平台(金蝶云星空API接口)所能接收的格式,并最终写入目标平台。这一过程需要精确地映射和转换数据,以确保数据的完整性和一致性。

数据请求与清洗

首先,从马帮系统中获取备货订单数据。通过调用马帮API hwc-shippbatch-get-shipment-list 接口,抓取最新的订单信息。为了处理分页和限流问题,可以使用批量请求和异步处理机制,确保数据不漏单且高效获取。

数据转换与写入

在获得原始数据后,需要对其进行清洗和转换,使之符合金蝶云星空的API要求。以下是具体的元数据配置示例:

{

"api": "batchSave",

"method": "POST",

"request": [

{"field": "FBillNo", "label": "单据编号", "type": "string", "value": "{shipmentId}-FH"},

{"field": "FStockOrgId", "label": "调入库存组织", "type": "string", "value": "100"},

{"field": "FDate", "label": "日期", "type": "string", "value": "{timeLastModified}"},

{"field": "FBillTypeID", "label": "单据类型", "type": "string", "value":"ZJDB01_SYS"},

...

],

...

}其中关键字段包括:

FBillNo:将马帮系统中的shipmentId转换为金蝶系统中的单据编号。FStockOrgId和FStockOutOrgId:库存组织ID,通过固定值或解析器(如ConvertObjectParser)进行转换。FDate:日期字段直接映射为马帮系统中的修改时间。FBillEntry:明细信息,包括物料编码、单位、调拨数量等字段,通过嵌套数组形式表示。

自定义数据转换逻辑

为了适应不同业务需求,可以自定义数据转换逻辑。例如,使用解析器将复杂字段进行映射:

{

...

{"field":"FMaterialId","label":"物料编码","type":"string","value":"{{localInfo.stockSku}}","parser":{"name":"ConvertObjectParser","params":"FNumber"}},

...

}此处,通过 ConvertObjectParser 将本地库存SKU映射为金蝶系统中的物料编码。

高吞吐量的数据写入能力

轻易云数据集成平台支持高吞吐量的数据写入能力,使得大量备货订单能够快速被集成到金蝶云星空中,提升了整体处理时效性。批量写入功能(如 batchArraySave)确保了大规模数据的高效传输。

数据质量监控与异常处理

在整个ETL过程中,实时监控和异常检测至关重要。通过集成平台提供的监控和告警系统,可以及时发现并处理数据问题,确保每个环节的顺利执行。同时,实现错误重试机制,在发生对接异常时自动重试,提高系统的鲁棒性。

金蝶云星空定制化数据映射对接

针对特定业务场景,可以定制化数据映射规则。例如,根据不同仓库发货需求设置相应字段:

{

...

{"field":"F_ora_Combo","label":"是否从马桥仓库发货","type":"string","value":"A"},

{"field":"F_ora_Combo3","label":"是否马桥仓库入库","type":"string","value":"B"},

...

}这些字段根据业务逻辑进行设定,确保每个订单按照正确的业务流程处理。

通过上述步骤,将源平台的数据成功转换并写入到目标平台金蝶云星空,实现了跨系统的数据无缝对接,为企业提供了高效、可靠的数据集成解决方案。