钉钉数据集成到金蝶云星空:修改下推的付款单③

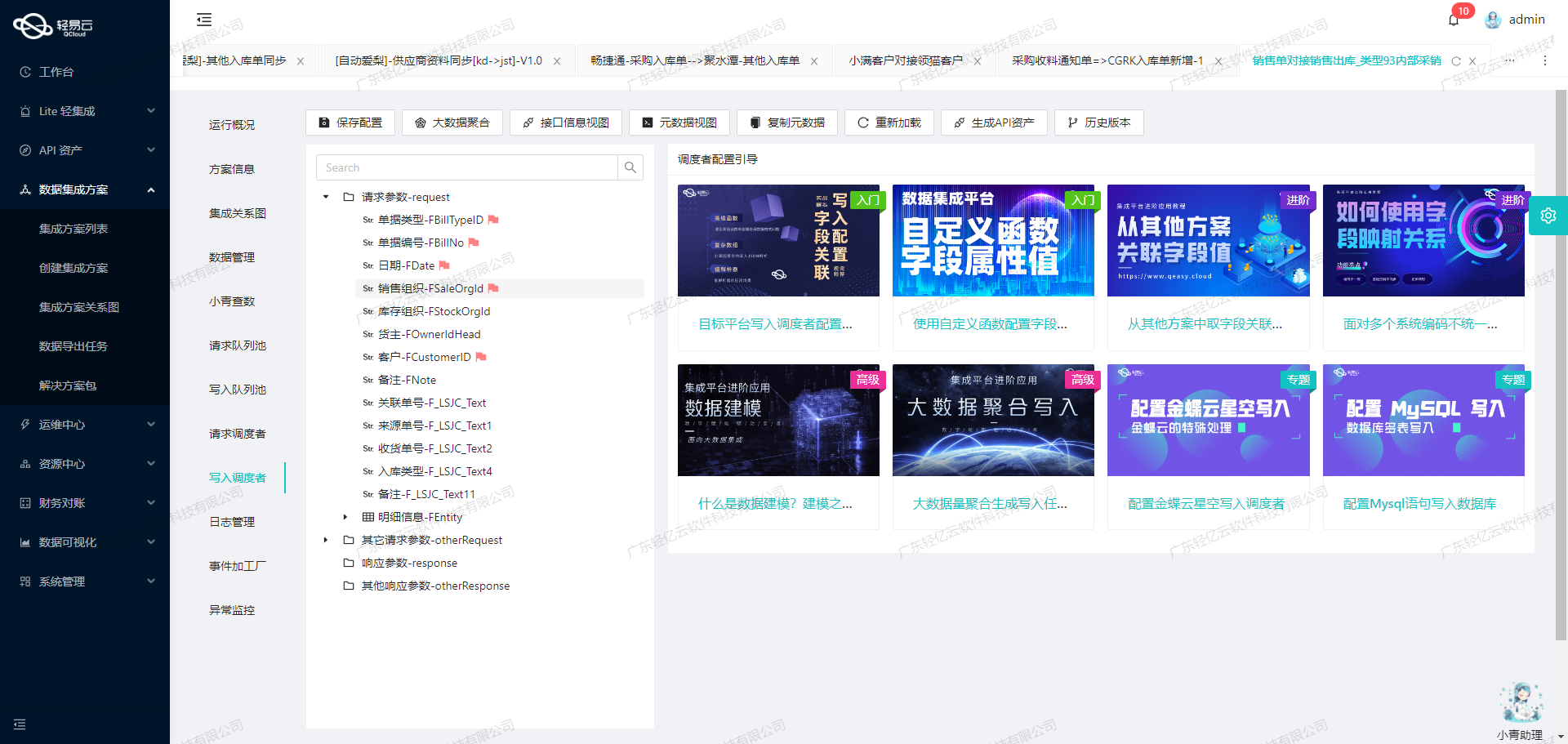

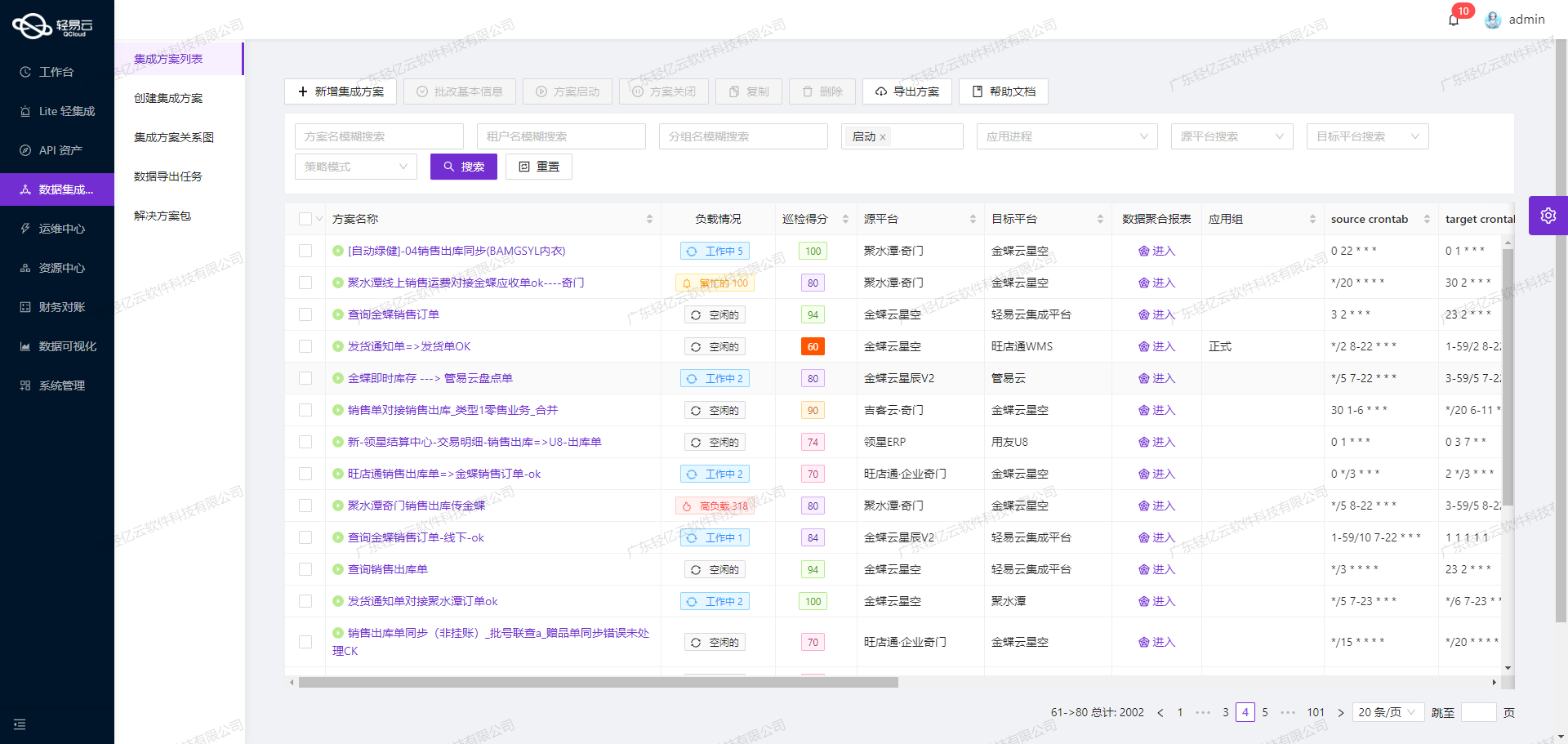

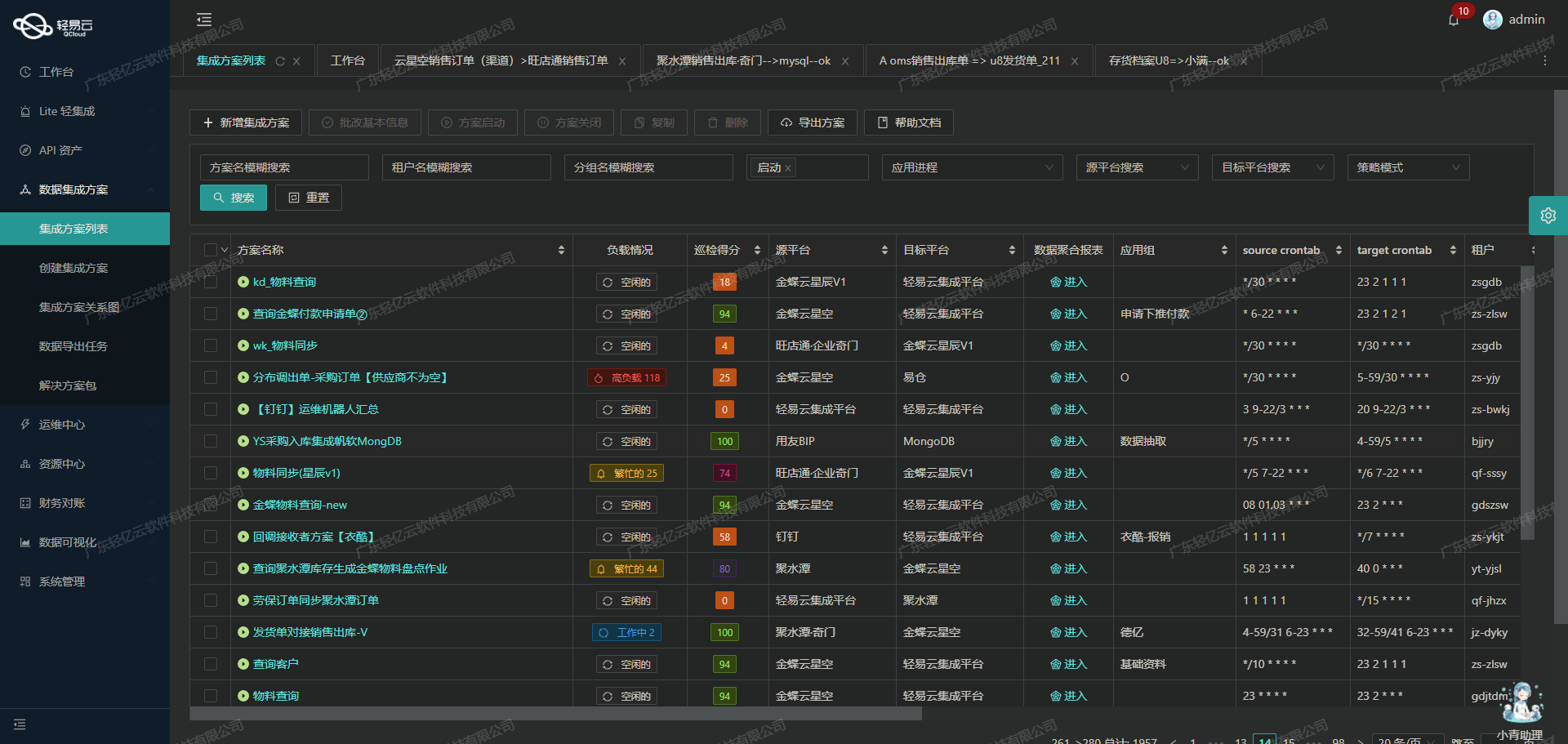

在企业信息化建设中,数据的高效流动和准确对接是关键。本文将分享一个实际案例,展示如何通过轻易云数据集成平台,将钉钉的数据无缝集成到金蝶云星空系统中,实现“修改下推的付款单③”这一具体业务需求。

背景与挑战

在本次集成任务中,我们需要从钉钉获取特定流程实例的数据,并将其批量写入到金蝶云星空系统。主要面临以下技术挑战:

- 高吞吐量的数据写入能力:确保大量数据能够快速且准确地被集成到金蝶云星空。

- 实时监控与告警:提供集中监控和告警系统,实时跟踪数据集成任务的状态和性能。

- API资产管理:通过统一视图和控制台,全面掌握API资产的使用情况,实现资源高效利用。

- 数据质量监控与异常检测:及时发现并处理数据问题,确保数据完整性和一致性。

- 自定义数据转换逻辑:适应特定业务需求和数据结构差异。

解决方案概述

为了实现上述目标,我们采用了以下技术方案:

-

调用钉钉接口topapi/processinstance/get:

- 定时可靠地抓取钉钉接口中的流程实例数据,确保不漏单。

- 处理分页和限流问题,以保证接口调用的稳定性。

-

批量写入到金蝶云星空batchSave API:

- 支持大量数据快速写入,提高整体处理效率。

- 实现定制化的数据映射对接,解决两者之间的数据格式差异。

-

实时监控与日志记录:

- 实现整个数据处理过程的透明化,通过可视化工具直观管理每个环节。

- 提供详细的日志记录功能,有助于后续排查问题。

-

异常处理与错误重试机制:

- 在对接过程中,如果出现异常情况,可以自动进行错误重试,提高系统的健壮性。

通过以上方案,我们不仅成功实现了从钉钉到金蝶云星空的数据无缝对接,还提升了整体业务流程的效率和透明度。在后续章节中,我们将详细介绍每个步骤及其具体实现方法。

调用钉钉接口topapi/processinstance/get获取并加工数据

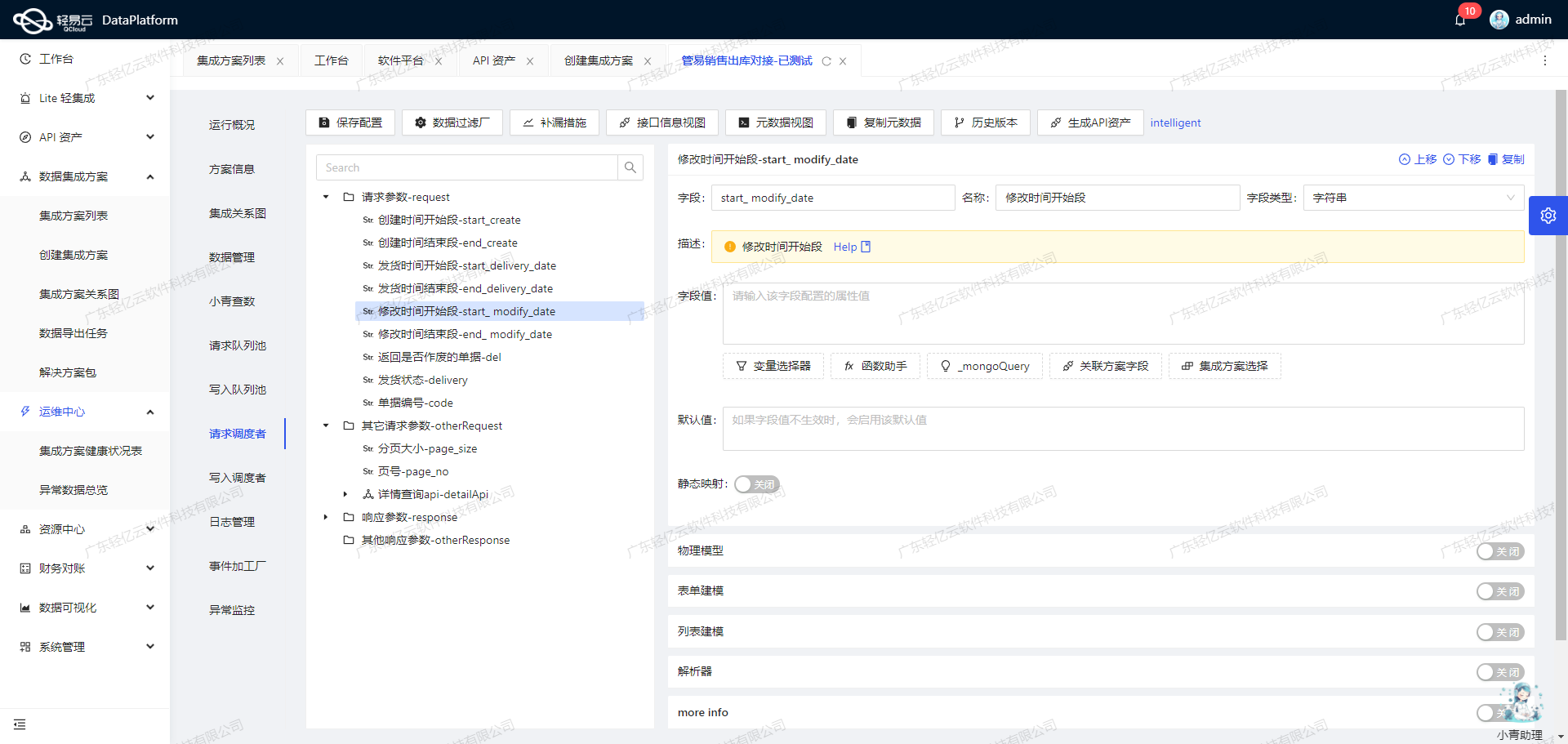

在轻易云数据集成平台的生命周期中,调用源系统接口是至关重要的一步。本文将详细探讨如何通过调用钉钉接口topapi/processinstance/get来获取并加工处理数据。

钉钉接口调用配置

首先,我们需要配置元数据,以便正确调用钉钉API。根据提供的元数据配置:

{

"api": "topapi/processinstance/get",

"method": "POST",

"number": "business_id",

"id": "单据编号",

"idCheck": true

}这一配置表明我们将使用POST方法,通过业务ID(business_id)来请求特定的单据编号(单据编号)。

数据请求与清洗

在发起API请求之前,需要确保业务ID的有效性。这可以通过预先检查和验证业务ID是否存在于我们的数据库中。如果启用了idCheck,则必须进行此验证步骤。

一旦验证通过,可以构建HTTP POST请求,并发送到钉钉API端点。示例如下:

POST /topapi/processinstance/get HTTP/1.1

Host: oapi.dingtalk.com

Content-Type: application/json

{

"process_instance_id": "<business_id>"

}成功响应后,将会收到包含所需单据信息的数据包。在这个阶段,需要对返回的数据进行初步清洗和过滤。例如,去除无关字段、标准化日期格式等。

数据转换与写入

接下来是数据转换阶段,根据业务需求对数据进行必要的转换。例如,将钉钉返回的数据结构映射到目标系统所需的数据模型中。这一步通常涉及字段重命名、类型转换以及复杂的逻辑运算。

假设我们需要将某些字段从原始响应中提取出来,并重新组织成目标格式:

{

"source_field_1": "<target_field_1>",

"source_field_2": "<target_field_2>"

}这种映射关系可以通过轻易云平台提供的可视化工具来实现,使得整个过程更加直观和易于管理。

实时监控与异常处理

为了确保集成过程的可靠性,实时监控和异常处理机制必不可少。轻易云平台提供了集中的监控和告警系统,可以实时跟踪每个数据集成任务的状态和性能。一旦发现异常,如网络超时或API限流问题,可以立即触发告警并执行相应的错误重试机制。

例如,在处理分页和限流问题时,可以设置自动重试策略,以确保所有数据都能被完整抓取而不漏单。这种机制极大地提升了数据处理的可靠性和稳定性。

自定义逻辑与优化配置

最后,为了适应特定业务需求,可以在轻易云平台上自定义数据转换逻辑。例如,如果需要对某些字段进行复杂计算或条件判断,可以编写自定义脚本来实现。此外,通过统一视图和控制台,企业可以全面掌握API资产的使用情况,实现资源高效利用和优化配置。

总之,通过合理配置元数据、精细化的数据请求与清洗、灵活的数据转换与写入,以及强大的实时监控与异常处理机制,我们能够高效地完成从钉钉获取并加工处理数据这一关键步骤,为后续的数据集成奠定坚实基础。

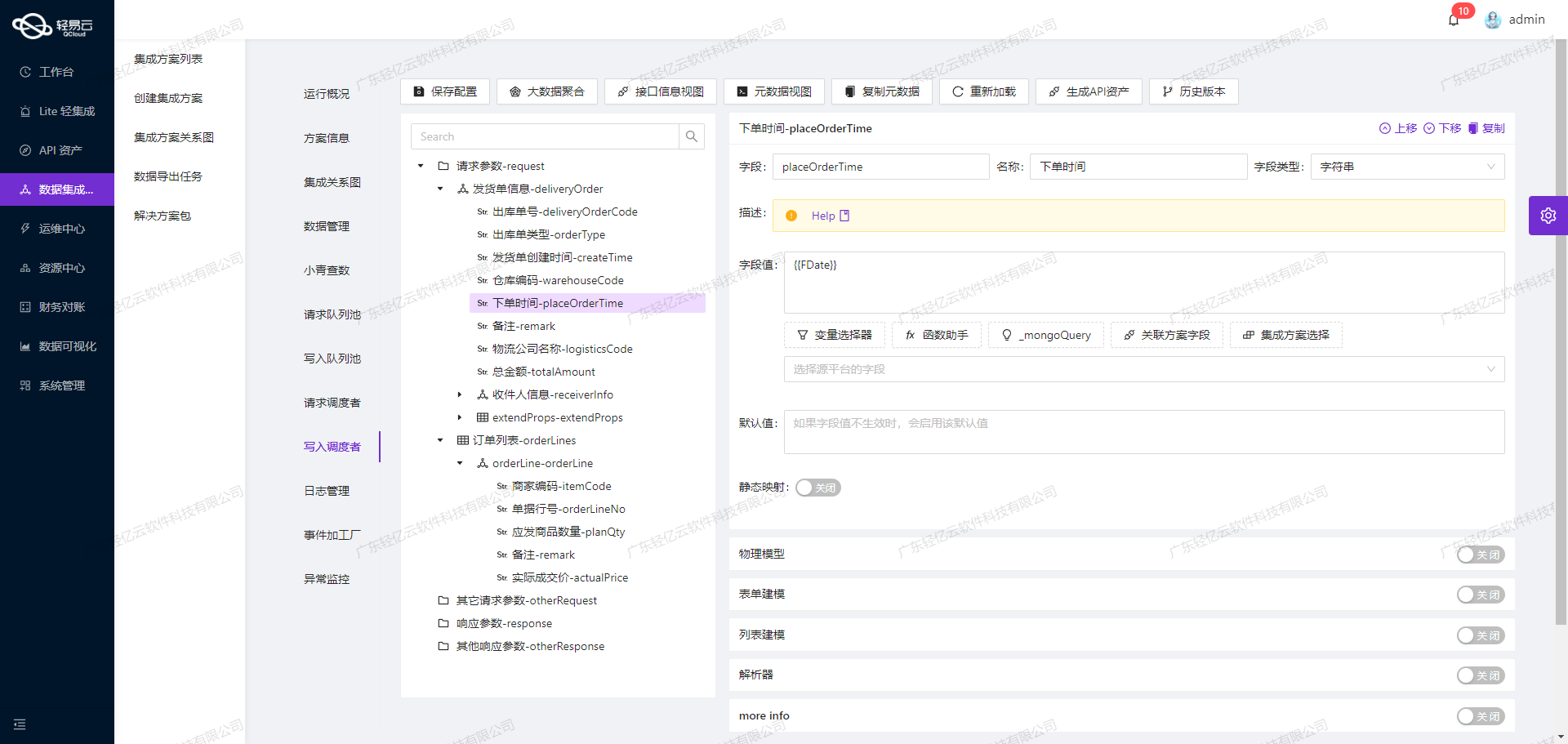

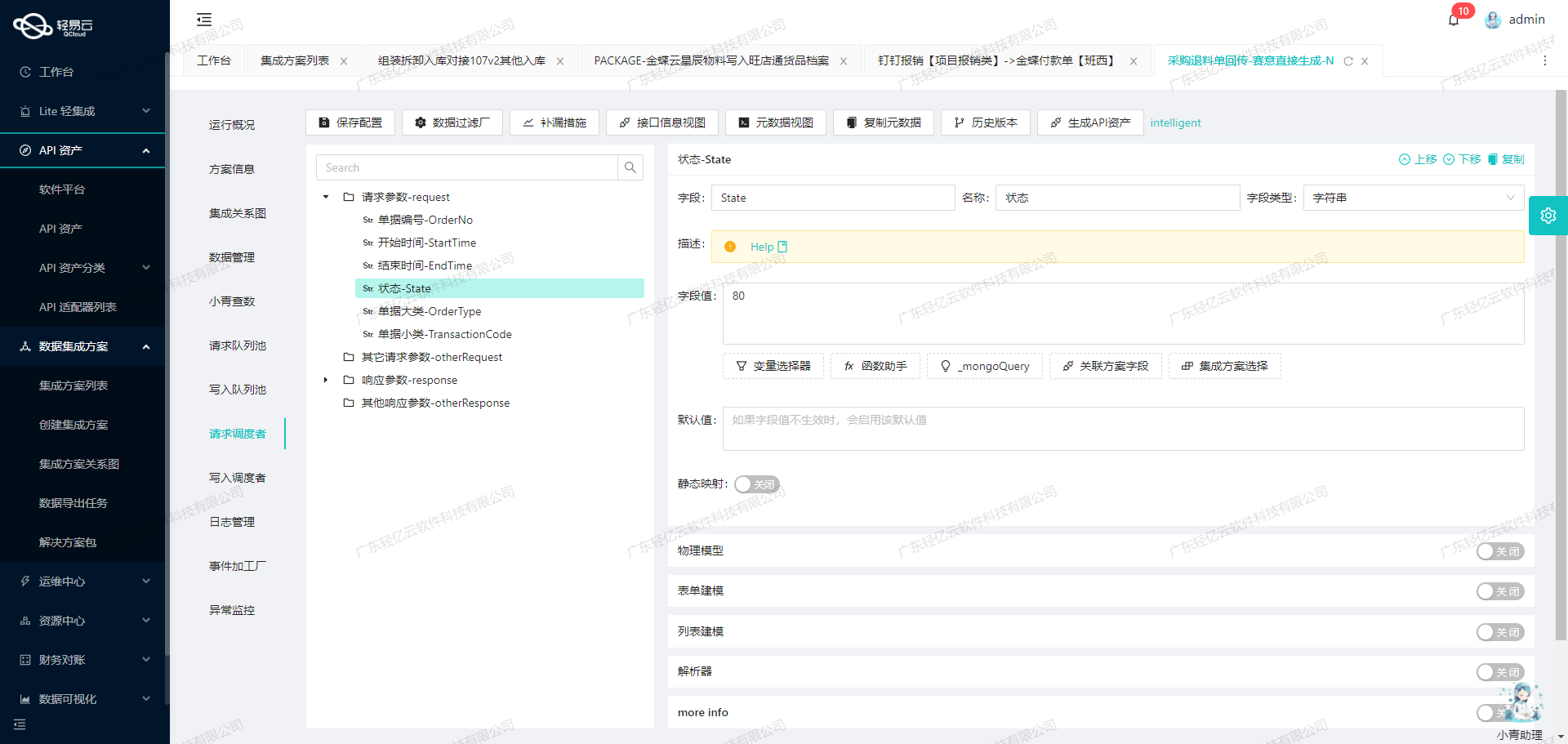

集成方案:修改下推的付款单③

在数据集成的过程中,ETL(提取、转换、加载)是关键步骤之一。将已经集成的源平台数据进行ETL转换,转为目标平台金蝶云星空API接口所能够接收的格式,是确保数据准确写入的核心环节。以下是具体操作步骤和技术细节。

数据提取与清洗

首先,我们从源平台提取原始数据,并进行初步清洗。这一步确保了数据的完整性和一致性,为后续的转换和加载打下基础。例如,从钉钉系统中获取付款单信息时,可以通过调用钉钉接口topapi/processinstance/get来获取所需的数据。

数据转换

在转换阶段,我们需要将提取到的数据按照金蝶云星空API接口所需的格式进行转换。以下是主要字段及其转换逻辑:

-

单据编号(FID):通过查找集合找到对应的FID。

{"field":"FID","label":"单据编号","type":"string","describe":"单据编号","value":"_findCollection find FID from b91e58dd-b358-385e-a6e9-58ae2b8c37ff where FBillNo={Number}"} -

货款属性(F_VAOJ_HKSX):根据货款属性进行条件判断并赋值。

{"field":"F_VAOJ_HKSX","label":"货款属性","type":"string","describe":"单据类型","value":"_function case '{{货款属性}}' when '成品' then 'CP' else 'FL' end"} -

备注(FREMARK):组合多个字段形成备注信息。

{"label":"备注","field":"FREMARK","type":"string","value":"{title}-{{收款人(公司名称)}}-{{备注}}"} -

单据编号(FBillNo):直接映射业务ID。

{"label":"单据编号","field":"FBillNo","type":"string","value":"{business_id}"}

数据写入

在完成数据转换后,下一步是将这些数据写入金蝶云星空系统。这一步需要调用金蝶云星空API接口,并根据元数据配置中的要求进行相应设置。

API接口调用配置

我们使用batchSave API方法,通过POST请求批量保存数据。以下是主要配置项:

- FormId:指定业务对象表单ID,如

AP_PAYBILL。 - Operation:指定执行操作类型为

BatchSave。 - IsAutoSubmitAndAudit:是否自动提交并审核,默认设为false。

- IsVerifyBaseDataField:是否验证基础资料有效性,默认设为false。

批量保存示例

{

"api": "batchSave",

"method": "POST",

"idCheck": true,

"operation": {

"method": "batchArraySave",

"rows": 1,

"rowsKey": "array"

},

"request": [

// 转换后的字段配置

],

"otherRequest": [

{"field": "FormId", "label": "业务对象表单Id", "type": "string", "value": "AP_PAYBILL"},

{"field": "Operation", "label": "执行的操作", "type": "string", "value": "BatchSave"},

{"field": "IsAutoSubmitAndAudit", "label": "提交并审核", "type": "bool", "value": false},

{"field": "IsVerifyBaseDataField", "label": "验证基础资料", "type": bool, value: false},

{"label": NeedUpDateFields, field: NeedUpDateFields, type: string, value: F_VAOJ_HKSX,FREMARK,FBillNo, parser: {name: StringToArray, params: ,}}

]

}异常处理与错误重试机制

在实际操作中,可能会遇到各种异常情况,例如网络超时、接口限流等。为了确保数据准确写入,需要实现异常处理与错误重试机制:

- 异常捕获:在每次API调用后,检查返回状态码和错误信息。如果出现异常,则记录日志并进入重试流程。

- 错误重试:设置重试次数和间隔时间,在一定次数内尝试重新提交请求。如果多次重试仍失败,则发出告警通知。

实时监控与日志记录

为了保障整个ETL过程的透明性和可追溯性,需要对每个环节进行实时监控和日志记录:

- 监控系统状态:通过轻易云平台提供的集中监控系统,实时跟踪数据集成任务的状态和性能。

- 日志记录:详细记录每次API调用、数据转换过程中的关键操作和结果,以便日后审计和问题排查。

通过上述步骤,可以有效地将源平台的数据进行ETL转换,并成功写入目标平台金蝶云星空,实现不同系统间的数据无缝对接。